Artefacts : un projet numérique sur l'archéologie de l'objet

Auteurs : M. Feugère (MOM), A. Gilles

Laboratoire : Archéologie et Archéométrie (ArAr)

Site internet : http://artefacts.mom.fr

Résumé :

La base de données librement accessible sur l'internet reflète une partie d’une base de travail enrichie en permanence par un réseau de chercheurs. Elle permet d’effectuer des recherches simples ou complexes.

Petits objets : définition

Qu 'est-ce qu'un "petit objet" ? Les spécialistes en discutent encore... Après la numismatique, dont le champ d'application (la monnaie) est assez bien défini, la céramologie a été la première à s'ériger en spécialité archéologique. Mais s'intéresse-t-elle au matériau (la terre cuite) ou à ce qu'on en fait ? De fait, beaucoup d'objets sont produits en argile, et le critère du matériau n'est pas le meilleur pour trier ce qui relèverait de la céramologie ou d'une nouvelle spécialité, celle concernant les objets. Au cours des dernières années s'est imposé le critère fonctionnel, qui permet de confier aux "céramologues" tout ce qui est vaisselle, de cuisine (préparation, service) ou de stockage (amphores...). Les "objets", qui ne sont pas toujours petits, c'est donc le reste.

Catégorie vaste, donc, et variée, puisqu'elle touche à presque tous les domaines de l'activité humaine. Pour mettre un peu d'ordre dans ce très vaste ensemble, Artefacts utilise un système hiérarchique à trois niveaux, sur lequel vient se greffer la chronologie. Chaque objet est attribué à une fonction, et chaque fonction entre dans un domaine. Ainsi un "dé à jouer" (code DEJ) appartient à la fonction "jeu-comptage", qui est elle-même insérée par le domaine socio-culturel. Il s'agit ici d'identifier la fonction première des objets, celle pour laquelle ils ont été conçus, et non leur réutilisation éventuelle dans un contexte secondaire (par exemple religieux, ou funéraire).

L'optique principale d'Artefacts est d'ordre typologique, mais certains types existent [presque] sous la même forme à des époques différentes. Un dé cubique en os, par exemple, pourra donc se trouver en DEJ-3, DEJ-4 ou DEJ-9 selon qu'il est étrusque, romain ou médiéval. Il est donc intéressant, quand on a trouvé le code de l'objet recherché (DEJ-, dans l'exemple ci-dessus), d'aller voir les attestations dans d'autres périodes, pour mesurer l'évolution de cette forme à travers le temps.

Nature et buts d'Artefacts

Artefacts n'est pas un produit fini, mais un programme évolutif reflétant le travail d'un groupe de chercheurs : la base de données est donc perfectible, et le lecteur attentif pourra y trouver des erreurs qui sont corrigées dès qu'elles nous sont signalées. Le but du projet est d'offrir un panorama aussi complet que possible des formes de petits mobiliers archéologiques classés par grandes périodes. Il n'est donc pas question ici de reunir un corpus d'objets, mais seulement un répertoire de formes ('types') pour lesquelles on fournit, autant que possible, une définition circonstanciée, une bibliographie choisie et une chronologie. Les objets cités et les illustrations fournies ne le sont évidemment qu'à titre d'exemple.

NB : l'ensemble de la documentation d'Artefacts provient de recherches archéologiques légales et de la bibliographie scientifique.

*****

Les Ateliers Pratiques Numériques en SHS des laboratoires lyonnais

Auteurs : Julien Barnier (CMW), Séverine Gedzelman (Triangle), Nicolas Genis (HiSoMA), Emmanuelle Morlock (HiSoMA), Hervé Parmentier (EVS), Samantha Saïdi (Triangle).

Laboratoires :

- Triangle (Action, Discours, Pensée politique et économique)

- HiSoMA (Histoire et Sources des Mondes Antiques)

- CMW (Centre Max Weber)

- EVS (Environnement Ville Société)

- LARHRA (Laboratoire de Recherche Historique Rhône-Alpes)

Mots-clefs : analyse de réseaux, analyse qualitative, analyse quantitative, bases de données, cartographie, édition numériques, formation, humanités numériques, numérique, pédagogie, SIG, XML-TEI.

Site internet : https://groupes.renater.fr/wiki/apn-shs/index

Résumé : Les Ateliers Pratiques Numériques en SHS (APN-SHS) ont été mis en place en 2015 par plusieurs laboratoires lyonnais (cités ci-dessus). Ces ateliers sont reconnus par l’Ecole Doctorale SCiences SOciales de l’Université de Lyon (ED 483).

Afin de pallier en partie le manque de formation initiale en informatique appliquée aux SHS, cinq laboratoires de Sciences humaines et sociales de la Communauté d’Etablissement Lyon-Saint-Etienne ont décidé de mettre en commun leurs efforts pédagogiques afin de proposer aux chercheurs et doctorants lyonnais un programme complet d’ateliers d’initiation à l’usage des outils et méthodes numériques en SHS. Ces ateliers et conférences sont organisés autour de 7 modules :

- Module « analyse qualitative » (1 conférence, 2 ateliers)

- Module « analyse quantitative » (1 conférence, 3 ateliers)

- Module « analyse de réseau » (1 conférence, 2 ateliers)

- Module « conception de bases de données » (1 conférence, 2 ateliers)

- Module « édition numérique, les fondamentaux » (2 ateliers)

- Module « pratiques du balisage de textes en XML/TEI » (1 conférence, 4 ateliers)

- Module « cartographie » (1 conférence, 4 ateliers)

Chaque module comprend au moins une conférence introductive et deux

ateliers.

L’objectif premier de ces conférences et de ces ateliers est de faire émerger chez les participants les questions préalables nécessaires au choix d’outils et de méthodes adaptés à leurs recherches. Cette réflexion est encouragée par le retour réflexif des intervenant.e.s sur leurs propres travaux et usages d’outils et méthodes numériques.

L'examen collectif des usages et des pratiques à partir de tous les points de vue des différents métiers des sciences humaines et sociales est également encouragé. Ainsi, ces ateliers s'adressent aussi bien aux doctorants qu'aux chercheurs, enseignants-chercheurs, ingénieurs et techniciens.

Plusieurs graphiques et tableaux illustreront, sur le poster, la fréquentation de chacun des 25 ateliers et conférences, ainsi que leur répartitionpar module thématique selon le statut (doctorant, docteur, ingénieur, enseignant, chercheur, masterant), la discipline et l’affiliation des participants.

*****

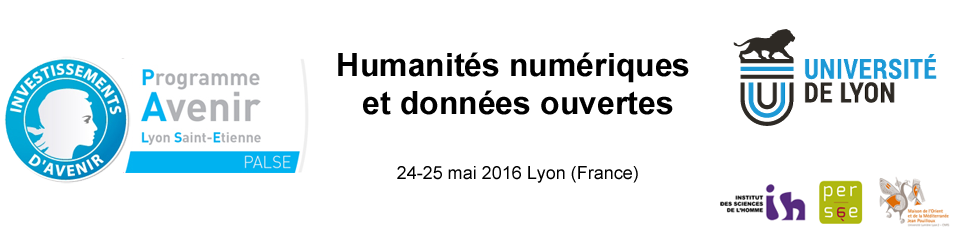

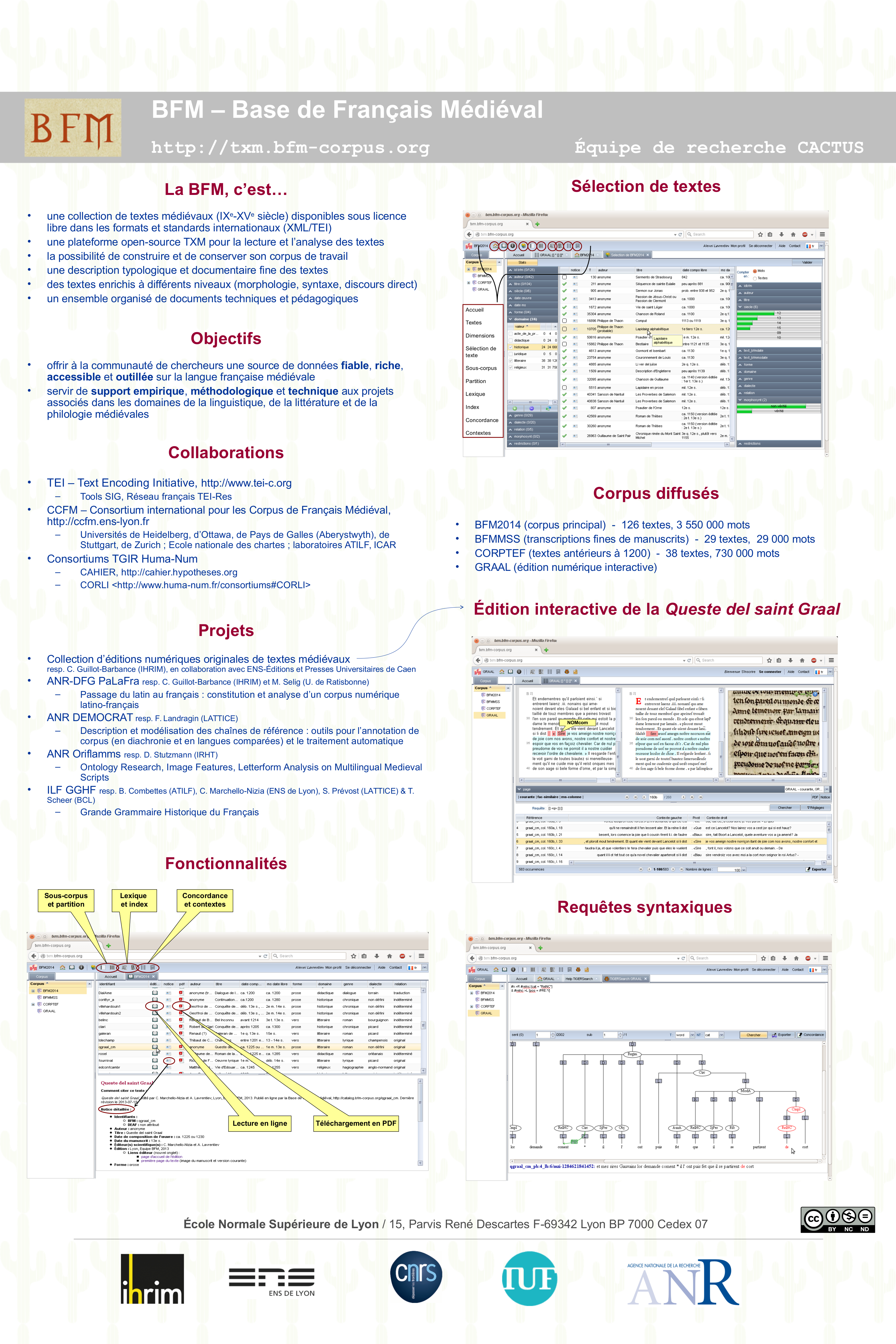

Base de français médiéval (BFM) :

une ressource ouverte au service de la communauté des médiévistes

Auteurs : Céline GUILLOT-BARBANCE (ENS de Lyon), Alexei LAVRENTIEV (CNRS), Serge HEIDEN (ENS de Lyon), Matthieu DECORDE (ENS de Lyon), Bénédicte PINCEMIN (CNRS)

Laboratoire : IHRIM (Institut d’Histoire des Représentations et des Idées dans les Modernités)

Contact : bfm <à> ens-lyon.fr

Mots-clés : linguistique diachronique, français médiéval, corpus de textes, édition numérique XML-TEI, philologie numérique, annotation morpho-syntaxique, plateforme d’analyse TXM

Site : http://txm.bfm-corpus.org

Résumé :

La Base de français médiéval est développée depuis 1989 à l’ENS de Lyon (anciennement ENS de Fontenay/Saint-Cloud). Elle était diffusée initialement sous la forme de concordances sur cédérom, puis interrogeable en ligne via le logiciel Weblex et actuellement par un portail TXM <http://txm.bfm-corpus.org>.

La BFM est l’un des corpus les plus importants pour la langue et la littérature française médiévale. Ses objectifs sont d’offrir à la communauté de chercheurs une source de données fiable (éditions de référence), riche, accessible et outillée sur la langue française médiévale et de servir de support empirique, méthodologique et technique aux projets développés dans les domaines de la linguistique, de la littérature et de la philologie médiévales. Actuellement, la BFM compte plus de 300 utilisateurs inscrits et le corpus principal (BFM2014) comporte 126 textes (près de 3 550 000 mots). Une mise à jour qui augmentera considérablement les dimensions de la Base est prévue pour l’été 2016.

Les textes de la BFM sont tous encodés en XML-TEI P5, et les fichiers sources, ainsi que les textes formatés pour l’impression (PDF) et le corpus « binaire » pour la version bureau de TXM, sont diffusés sous une licence libre CC BY-NC-SA. L’ensemble de la BFM est étiqueté en morphosyntaxe par un outil automatique et une vingtaine de textes dispose d’un étiquetage vérifié.

Pour exploiter les données de la BFM, les utilisateurs disposent de l’ensemble des outils d’analyse qualitative et quantitative mis à disposition par la plateforme TXM. Ces outils incluent, entre autres, les concordances KWIC, les index de formes et de motifs, la création de sous-corpus et de partitions, le calcul de spécificités et l’analyse factorielle de correspondances. Le retour au texte de l’édition est toujours possible, avec éventuellement une vue synoptique du facsimilé de la source (voir l’édition numérique interactive de la Queste del saint Graal : http://catalog.bfm-corpus.org/qgraal_cm).

Les recherches propres de l’équipe BFM portent sur l’oral représenté dans les textes médiévaux, sur le passage du latin au français, sur les démonstratifs et les chaînes de référence, sur l’évolution de la syntaxe et sur les systèmes graphiques de manuscrits médiévaux. Plusieurs projets financés (ANR, ANR-DFG) se sont appuyés sur les données de la BFM et ont en même temps permis d’enrichir la Base qualitativement et quantitativement. Les principaux projets ayant contribué au développement de la BFM sont les suivants : ANR CoRPTeF <http://corptef.ens-lyon.fr>, ANR Textométrie <http://textometrie.ens-lyon.fr>, ANR-DFG SRCMF <http://srcmf.org>, ANR Oriflamms <http://oriflamms.hypotheses.org>. Les projets en cours (ANR-DFG PaLaFra et ANR Democrat) assurent la continuité du développement de la Base. L’équipe de la BFM participe activement à plusieurs réseaux de recherche français et internationaux : les consortiums Huma-Num CAHIER <http://cahier.hypotheses.org> et CORLI <http://www.huma-num.fr/consortiums#CORLI>, le consortium TEI <http://www.tei-c.org>, les communautés Digital Medievalist <http://digitalmedievalist.org> et Textual Heritage <http://textualheritage.org>.

Dans l’avenir la BFM compte s’enrichir par de nouvelles annotations, par de nouvelles éditions ouvertes, nativement numériques, et s’intégrer davantage dans toutes sortes de corpus et bibliothèques virtuelles.

*****

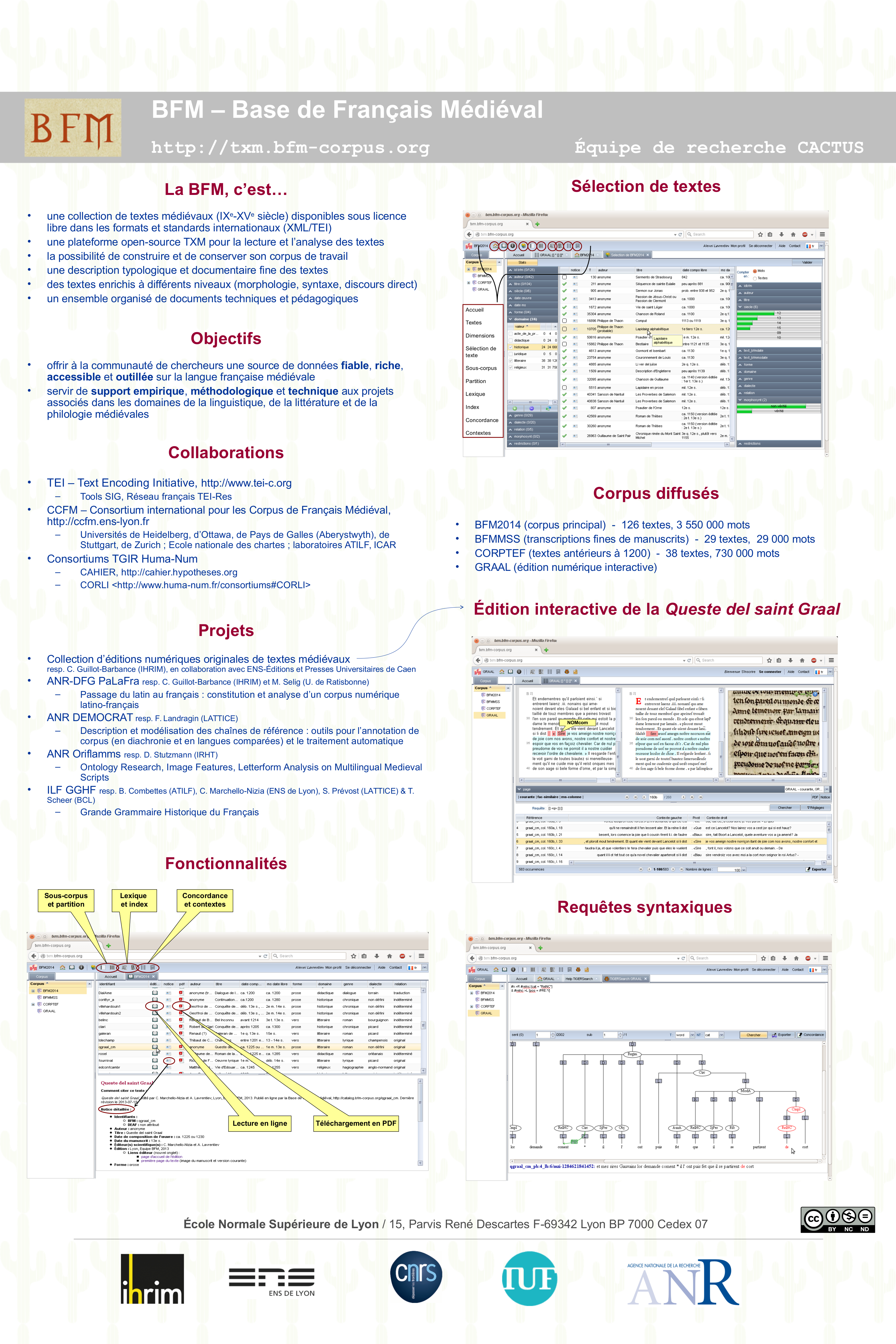

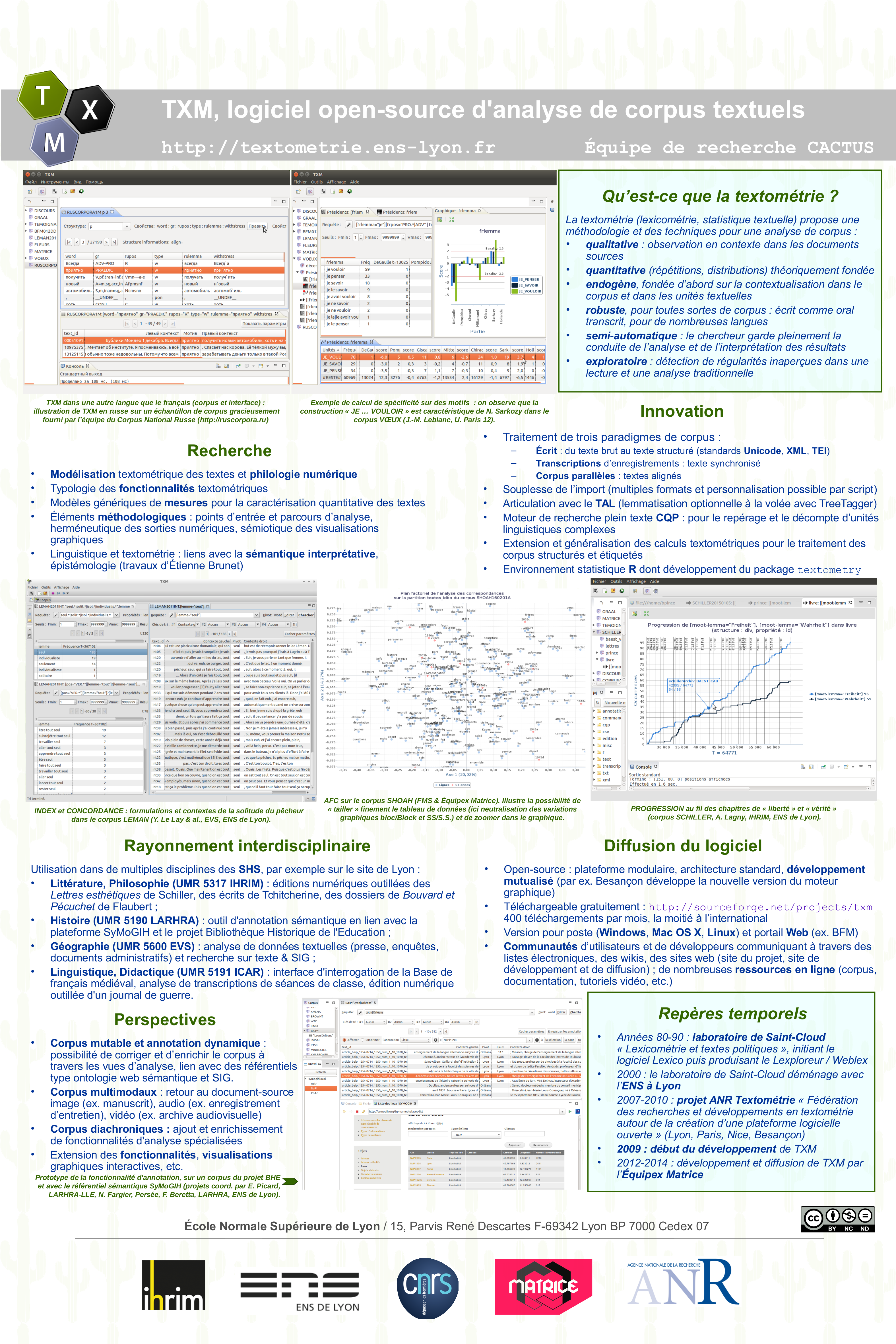

TXM, plateforme open-source d'analyse de corpus textuels

Auteurs : Serge HEIDEN (ENS de Lyon), Bénédicte PINCEMIN (CNRS), Matthieu DECORDE (ENS de Lyon), Alexei LAVRENTIEV (CNRS), Céline GUILLOT-BARBANCE (ENS de Lyon)

Laboratoire : IHRIM (Institut d’Histoire des Représentations et des Idées dans les Modernités)

Contact : textométrie <à> ens-lyon.fr

Mots-clés : analyse qualitative et quantitative de textes, textométrie, statistiques textuelles, bibliothèque statistique R, encodage numérique de sources XML et TEI, traitement automatique de la langue, TAL, mise en ligne d'éditions numériques outillées

Sites :

Site du projet : http://textometrie.ens-lyon.fr

Site du logiciel : https://sf.net/projects/txm

Portail de démonstration : http://portal.textometrie.org/demo

Résumé :

Depuis 2009 l'équipe Cactus, sur le site de l'ENS de Lyon, implémente ses recherches en textométrie en coordonnant le développement de la plateforme open-source d'analyse de corpus TXM. TXM est un logiciel textométrique nouvelle génération, au développement communautaire et capable de prendre en compte les informations de corpus encodés selon les standards philologiques les plus riches (eg TEI) et enrichis linguistiquement de façon automatique (eg lemmatisation) <http://textometrie.ens-lyon.fr>.

La textométrie propose une méthodologie d'analyse de corpus à la fois qualitative et quantitative, pour toutes sortes de corpus (écrit comme oral transcrit, du texte « brut » tout venant au texte précisément encodé en XML-TEI) comme pour de nombreuses langues. L'approche textométrique intéresse ainsi toutes les disciplines scientifiques recourant à l'analyse de données textuelles, notamment la plupart des sciences humaines et sociales.

Sur le site de Lyon par exemple, l'équipe TXM est en lien avec des littéraires et philosophes (UMR 5317 IHRIM, éditions numériques outillées des Lettres sur l'éducation esthétique de Schiller, des écrits de Tchitcherine, des dossiers de Bouvard et Pécuchet de Flaubert), des historiens (UMR 5190 LARHRA, outil d'annotation sémantique en lien avec la plateforme SyMoGIH et le projet Bibliothèque historique de l'éducation), des géographes (UMR 5600 EVS, analyse de données textuelles (presse, entretiens d'enquêtes, documents législatifs) et recherche sur texte & SIG), des linguistes et didacticiens (UMR 5191 ICAR, interface d'interrogation de la Base de français médiéval, analyse de transcriptions de séances de classe, édition numérique outillée d'un journal de guerre).

La plateforme TXM est diffusée sous la forme de deux logiciels gratuits : le logiciel TXM pour poste de travail Windows, Mac et Linux, et le logiciel portail TXM pour serveur web <http://txm.sf.net>. Elle adopte les standards qui font internationalement référence dans le domaine (Unicode, XML, TEI pour les sources textuelles et Java, OSGi, XSLT2, HTML5 pour les composants logiciels) et des composants open-source de référence (moteur de recherche plein texte CQP, environnement statistique R, plateforme Eclipse RCP, plateforme GWT, etc.). La communauté des utilisateurs de TXM est animée par le biais de deux listes de diffusion (txm-users, txm-open) et d'un site wiki <https://groupes.renater.fr/wiki/txm-users>.

*****

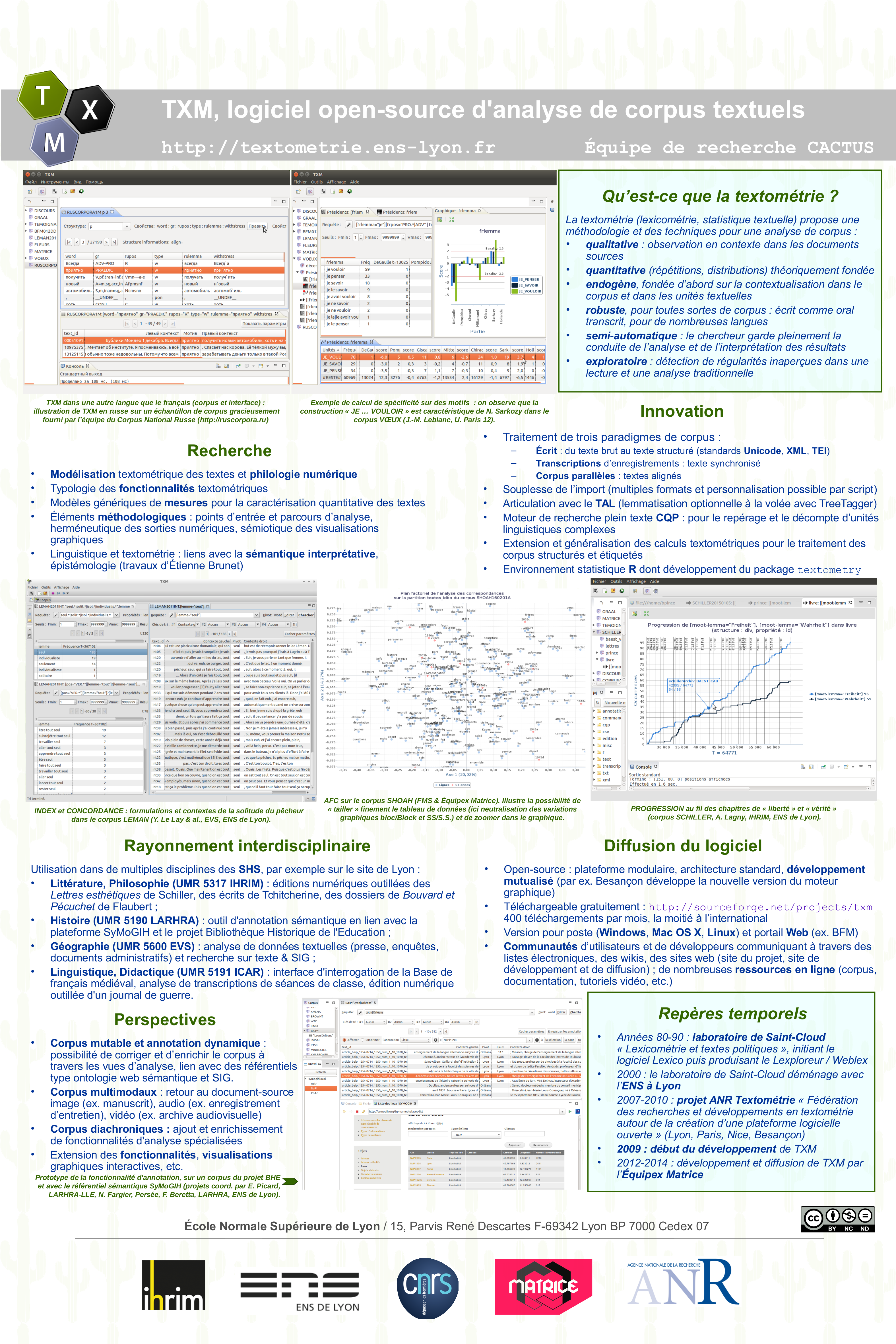

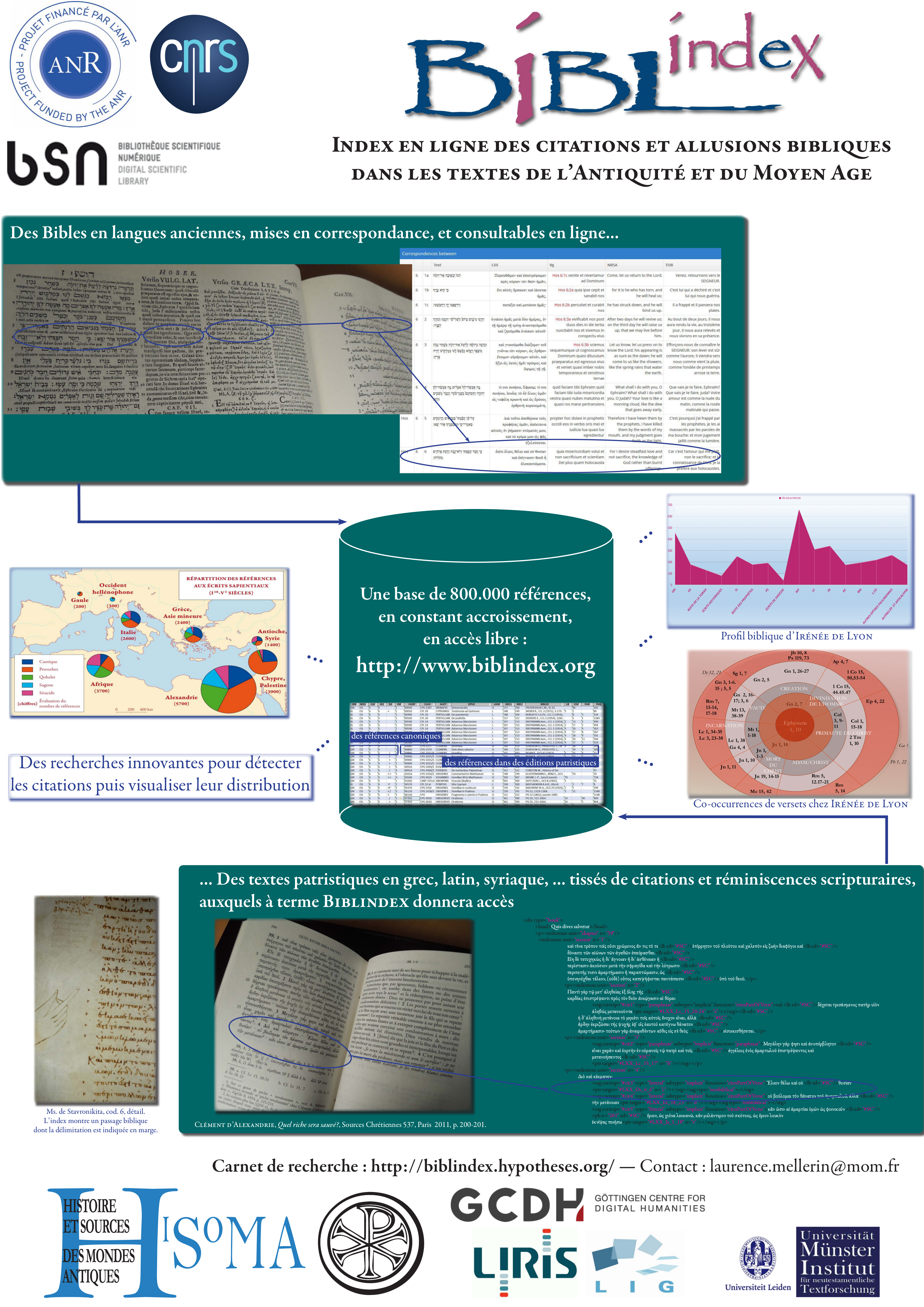

Biblindex, index en ligne des citations bibliques

dans les textes chrétiens de l'Antiquité et du Moyen Age

Auteurs : L. Mellerin, pour l'équipe des Sources Chrétiennes (MOM)

Laboratoire : HiSoMA (Histoire et Sources des Mondes Antiques)

Mots-clés : Bibles, intertextualité, patristique, langues anciennes, citation

Site : http://www.biblindex.info

Résumé :

Ce projet d'index en ligne des citations bibliques dans les textes anciens, à visée exhaustive, est porté par l’Institut des Sources Chrétiennes, composante du laboratoire HiSoMA (UMR 5189), en partenariat avec deux laboratoires d’informatique rhônalpins, le LIRIS et le LIG, et deux instituts européens de recherche biblique (INTF de Münster, Peshitta Institute de Leyde). Il bénéficie du soutien de l’Agence Nationale de la Recherche (2011-2015) et de celui du MESR (BSN5, 2015-2016).

Le corpus est essentiellement constitué de textes chrétiens des six premiers siècles, écrits en grec et en latin ; il s’étend peu à peu aux domaines orientaux (syriaque, arménien, copte, …) et à des périodes plus tardives.

A terme, le corpus Biblindex donnera accès aux textes mêmes, et non plus seulement à des références chiffrées renvoyant à des éditions imprimées.

La recherche consacrée à l’identification semi-automatique des citations et allusions aura de multiples applications. Des techniques innovantes pour la construction de visualisations géo-temporelles des données sont aussi en cours de développement.

Sur le site figure également une mise en correspondance très fine des principales versions anciennes de la Bible, accompagnées de traductions en anglais et en français, qui permet de comparer entre elles des citations faites dans des langues différentes.

Grâce à une plate-forme collaborative, des spécialistes des domaines bibliques et patristiques contribueront à la réalisation de cet outil commun aux philologues, aux théologiens, aux historiens, mais aussi utile au grand public désireux de mieux connaître la réception de la Bible.

*****

Les Dossiers documentaires de Bouvard et Pécuchet

Auteurs : S. Dord-Crouslé (Resposable scientifique du projet, CNRS)

Laboratoire : IHRIM (Institut d’Histoire des Représentations et des Idées dans les Modernités)

Mots-clés : Humanités numériques, Littérature, Édition électronique, Textes fragmentaires, Collection numérique, Documentation, Critique génétique, Manuscrits, Roman inachevé, XML-TEI

Site de la vidéo : http://25images.ish-lyon.cnrs.fr/bouvard-pecuchet/video/diaporama-video/fr

Site du projet : http://www.dossiers-flaubert.fr

Résumé :

La vidéo a été réalisée par le Pôle Image Animée de l’ISH. Elle rappelle les objectifs du projet et explique le fonctionnement du site d’édition.

Lancé en 2005 et financé par l’ANR entre 2008 et 2012, le projet d’édition des dossiers documentaires de Bouvard et Pécuchet(http://www.dossiers-flaubert.fr/) concerne le dernier roman de Flaubert, posthume et inachevé. L’œuvre devait comporter deux volumes, mais la mort de l’écrivain, le 8 mai 1880, a empêché la rédaction du second. Conservés à la bibliothèque de Rouen, les documents destinés à cette rédaction n’étaient connus que par des extraits ou des éditions partielles opérant des choix discutables alors que l’instabilité fondamentale des fragments textuels oblige à leur conserver une mobilité qui se trouve nécessairement défaite par la fixité d’une édition imprimée. En recourant aux possibilités offertes par l’informatique, le projet s’est donné pour but de corriger ce biais et de conserver au corpus sa mobilité en permettant la production de seconds volumes à la demande.

Le projet avait donc deux objectifs intrinsèquement liés : d’une part, rendre accessible un corpus complexe sous la forme d’une édition en ligne ; d’autre part, permettre à tout internaute de produire des agencements paramétrables de citations extraites du corpus, des agencements qui sont autant de seconds volumes possibles répondant à la formulation d’hypothèses diverses. L’articulation des deux volets du projet repose sur l’utilisation du format pivot XML-TEI : l’encodage du corpus permet à la fois la visualisation et le découpage des fragments textuel, et donc leur manipulation.

La vidéo illustre les deux dimensions du projet qui, au-delà de l’intérêt qu’il revêt pour les spécialistes du domaine, présente plus largement une tentative originale et novatrice pour étendre le champ de l’édition critique aux contenus textuels fragmentaires.

*****

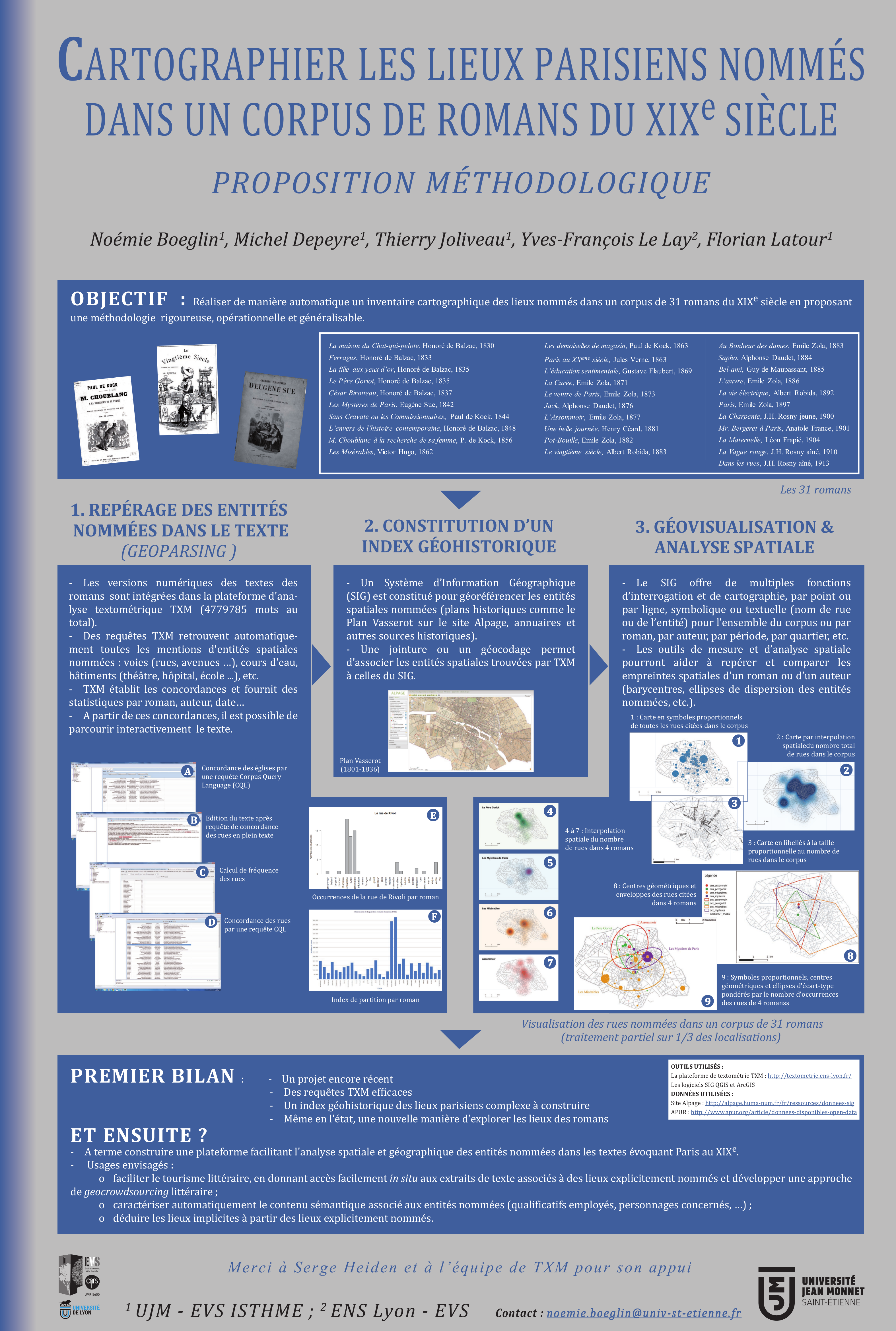

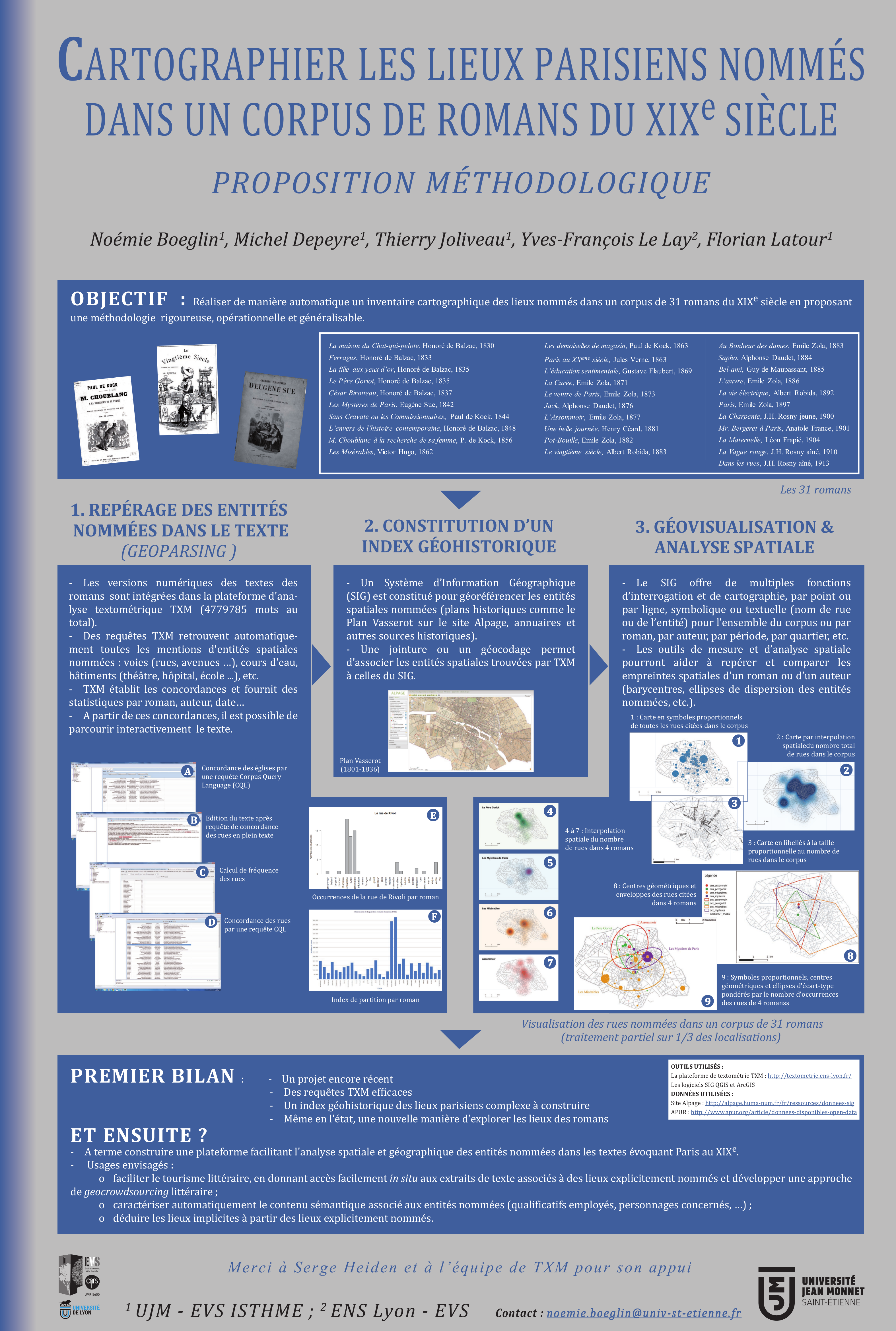

Cartographier les lieux parisiens nommés dans un corpus de romans du XIXe siècle

Proposition méthodologique

Auteurs : Noémie Boeglin (UJM, EVS), Michel Depeyre (UJM, EVS), Thierry Joliveau (UJM, EVS), Yves Le Lay (ENS de Lyon, EVS), Florian Latour (UJM, EVS)

Laboratoires : Université Jean Monnet Saint-Etienne et ENS de Lyon, EVS (Environnement Villes et Sociétés)

Contact : thierry.joliveau@univ-st-etienne.fr

Mots-clés : XIX° siècle, analyse textuelle, cartographie, histoire urbaine, Paris, romans, SIG

Résumé :

Dans le cadre de sa thèse d'histoire sur les paysages parisiens évoqués dans 31 romans du XIXe siècle, Noémie Boeglin effectue un inventaire cartographique des lieux nommés dans son corpus. Pour dépasser un inventaire manuel, fastidieux et approximatif, l'équipe propose de construire une méthodologie rigoureuse, opérationnelle et généralisable, qui permettrait de localiser et cartographier le plus automatiquement possible et d’analyser spatialement les occurrences citées par roman, par auteur ou par date. L'objectif à terme plus lointain est de construire une plateforme facilitant l'analyse cartographique d'autres textes évoquant Paris à la même époque.

La méthode expérimentée associe l'usage d'une plateforme d'analyse textuelle quantitative TXM et l’élaboration d’un Système d'Information Géographique adapté, supportant un gazetier (atlas toponymique) des lieux parisiens entre 1830 et 1914 et de fournir une interface de géovisualisation. Il faut d'abord rassembler et corriger les versions numériques des textes des romans, souvent fautives car tirées de procédures OCR. Ensuite l'écriture de requêtes adaptées dans TXM permet de retrouver automatiquement toutes les mentions d'entités spatiales nommées de types variés : voies (rue, avenue, boulevard, quai etc.) en priorité, mais aussi les cours d'eau (rivière, bassin, canal...), les bâtiments (théâtre, hôpital, école ...), les quartiers ou communes, les parcs et autres toponymes. En parallèle, une recherche sur les plans historiques de Paris permet de trouver des sources cartographiques valables pour localiser ces entités nommées. Pour le début de la période (1830), il a été décidé de prendre comme référence les données du plan Vasserot, disponibles au téléchargement en ligne sur le site Alpage, aux formats raster et vecteur (bâtiments, voies, quartiers). Pour les années 1900, nous nous appuyons sur un plan de rues de l'époque qui a été géoréférencé pour disposer des rues apparues lors de l'extension tout le long du XIXe et des rénovations haussmanniennes. Tout ce travail de référencement par rues permettra bien entendu de visualiser les localisations romanesques sur les plans contemporains dans une logique de valorisation par le tourisme littéraire.

La recherche vise aussi à expérimenter et à proposer des formes de cartographie adaptées à ce type spécifique de phénomène. Le travail de constitution de gazetier et de cartographie est en cours et les premiers résultats seront présentés dans le poster. En conclusion, précisons que l'équipe ne pense pas du tout que la dimension géographique des romans ni même les questions de localisation romanesque puissent se réduire à une cartographie des entités nommées. Il nous semble que celles-ci, qu’il est possible de localiser de manière automatique ou semi-automatique, peuvent constituer un cadre de référence utile pour cartographier les lieux des romans non nommés explicitement. Valider cette hypothèse constituera un objectif de la deuxième phase de la recherche, qui s’intéressera aussi à la question de la caractérisation par analyse textuelle des entités nommées repérées.

*****

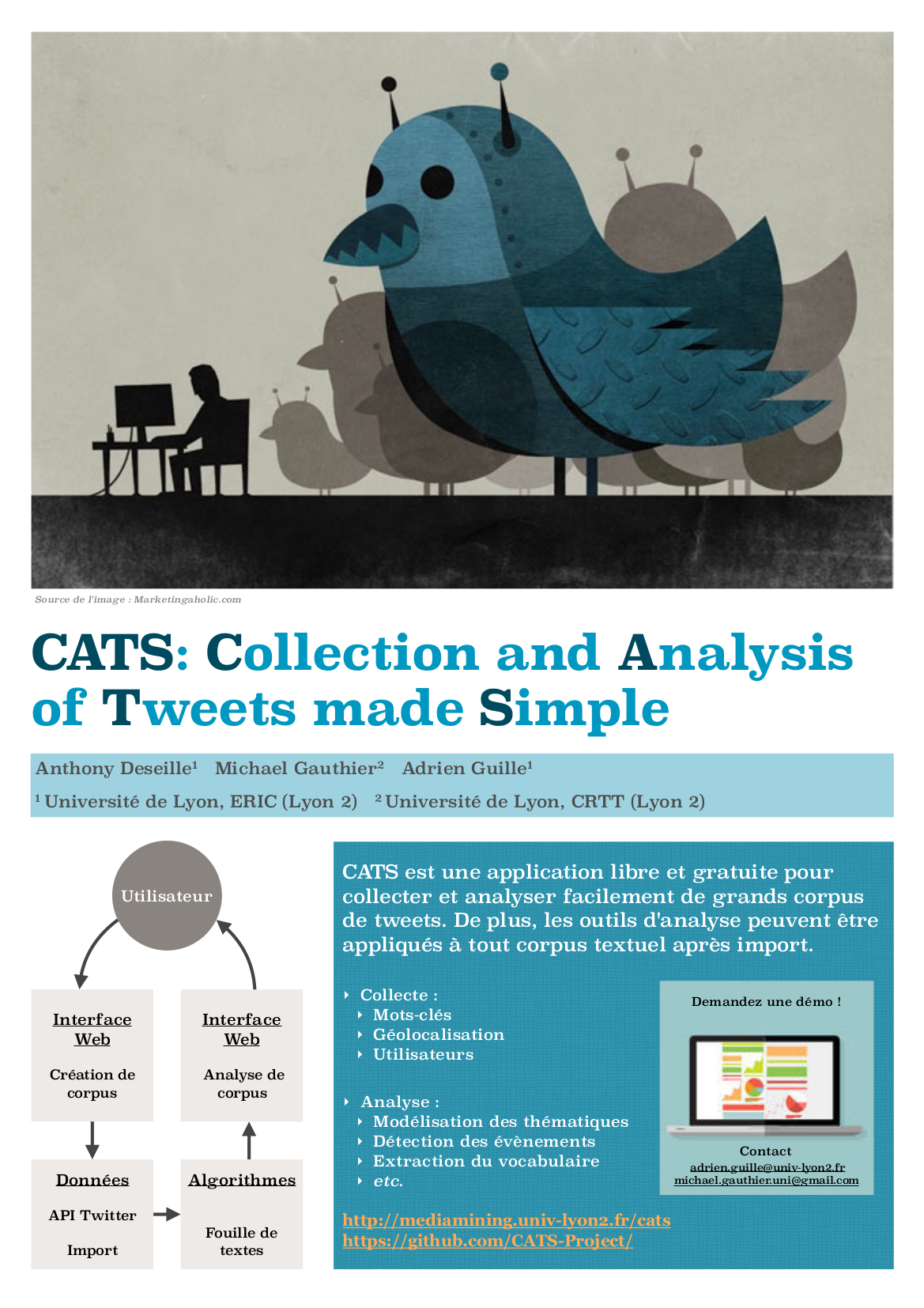

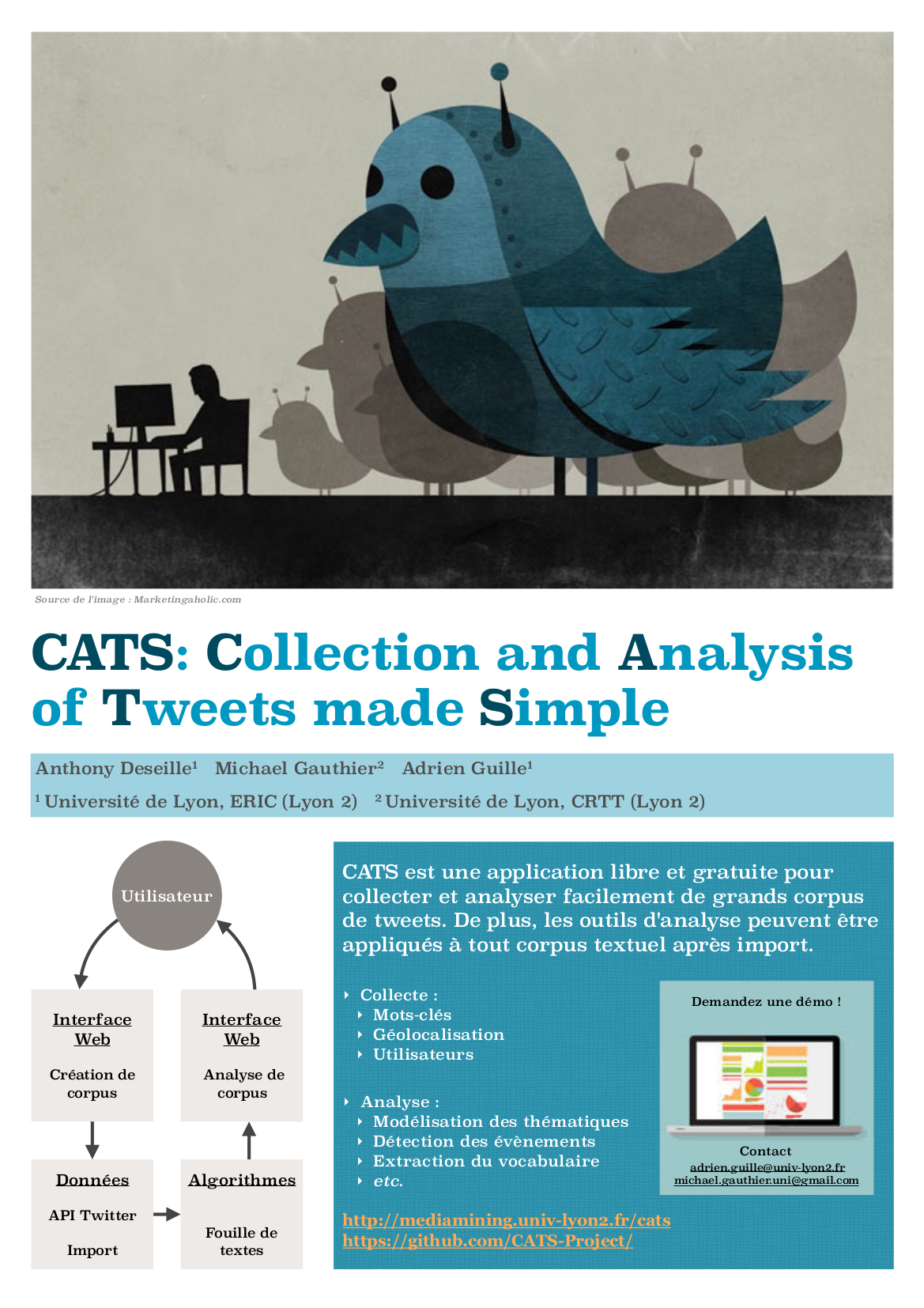

CATS : Collection and Analysis of Tweets made Simple

Exploitation de Twitter pour les Humanités Numériques

Auteurs : M. Gauthier*, A. Guille** et A. Deseille* (Université Lyon 2)

Laboratoires :

*Université de Lyon, ERIC (Entrepôts, Représentation et Ingénierie des Connaissances)

**Université de Lyon, CRTT (Centre de recherche en terminologie et traduction)

Mots-clés : Twitter ; Collecte de grands corpus textuels ; Analyse de grands corpus textuels

Sites :

Accès à CATS : http://mediamining.univ-lyon2.fr/cats

Sources de CATS : https://github.com/CATS-Project/

Résumé :

Avec près d’un demi milliard de tweets émis chaque jour à travers le monde [1], Twitter représente un moyen extrêmement intéressant de collecter de grands volumes de données numériques textuelles, et ce en temps réel. De nombreux chercheurs de divers domaines, notamment les chercheurs en sciences humaines et sociales, souhaiteraient d’ailleurs exploiter ces données pour leurs travaux. Néanmoins, ces chercheurs font souvent face à plusieurs obstacles. D’abord, la collecte de ces données n’est pas aisée, car cela requiert des compétences poussées en programmation informatique. Ensuite, l’analyse de ces grands volumes de données textuelles nécessite la mise en oeuvre de techniques informatiques complexes. Enfin, la collecte comme l’analyse de ces données demandent des ressources matérielles importantes. Ces obstacles tendent à restreindre l’accès à ces données une catégorie particulière de chercheurs. La plupart du temps donc, les personnes n’ayant pas les compétences et les ressources informatiques nécessaires ne peuvent pas utiliser Twitter pour leurs travaux, limitant ainsi l’implication des chercheurs en sciences humaines et sociales par exemple dans la recherche liée aux humanités numériques.

Il existe déjà des solutions permettant de dépasser certains de ces obstacles, mais celles-ci sont soit trop peu performantes, soit trop peu intuitives, soit payantes. C’est la raison pour laquelle nous proposons de présenter CATS (Collection and Analysis of Tweets made Simple), un outil que nous développons [2]. CATS est une application en ligne gratuite, hébergée à l’université Lyon 2, visant à rendre accessible à n’importe qui la collecte et l’analyse de grands volumes de tweets, car nous pensons que les humanités numériques, et l’outil que représente Twitter plus spécifiquement, ne doivent pas être fermés à une certaine catégorie de chercheurs à cause de limitations techniques. Le but de cette application est donc de fournir un outil intuitif et facile à utiliser, qui permettra à n’importe quel chercheur de profiter des données de Twitter pour sa recherche grâce à différentes méthodes de collecte de tweets (selon des mots-clés, selon une zone géographique ou encore selon des auteurs). Une fois un corpus de tweets collecté, il est possible de l’explorer, et de le diviser en différents sous-corpus selon les besoins spécifiques du chercheur (contenu des tweets, date de publication, auteurs etc. . . ). En outre, CATS offre un panel d’outils d’analyse (extraction du vocabulaire, modélisation des thématiques, détection d’évènements) et de visualisation permettant une exploration bien plus profonde des données.

Nous espérons que grâce à cette plateforme et au fait que les barrières techniques soient levées, de nouvelles passerelles se créeront entre les chercheurs de différents domaines. Plusieurs collaborations ont déjà vu le jour grâce à ce projet [2,3], et le cas d’une étude sociolinguistique synchronique portant sur l’utilisation genrée de la vulgarité au Royaume Uni sera prise en exemple pour illustrer les possibilités offertes par CATS. Nous présenterons donc le fonctionnement général de CATS et son but, ainsi que certains des résultats obtenus dans l’étude sur la vulgarité afin d’illustrer les possibilités offertes pas CATS en terme de fouille de données.

RÉFÉRENCES

[1] Krikorian, R. (2013). “New Tweets per second record, and how!” Twitter Official Blog.

[2] Truica, C. O., Guille, A., Gauthier, M. (2015). “CATS: Collection and Analysis of Tweets Made Simple”, In Proceedings of the

19th ACM Conference on Computer Supported Cooperative Work and Social Computing Companion.

[3] Gauthier, M., Guille, A., Rico, F., Deseille, A. (2015). “Text Mining and Twitter to Analyze British Swearing Habits”. Handbook

of Twitter for Research.

*****

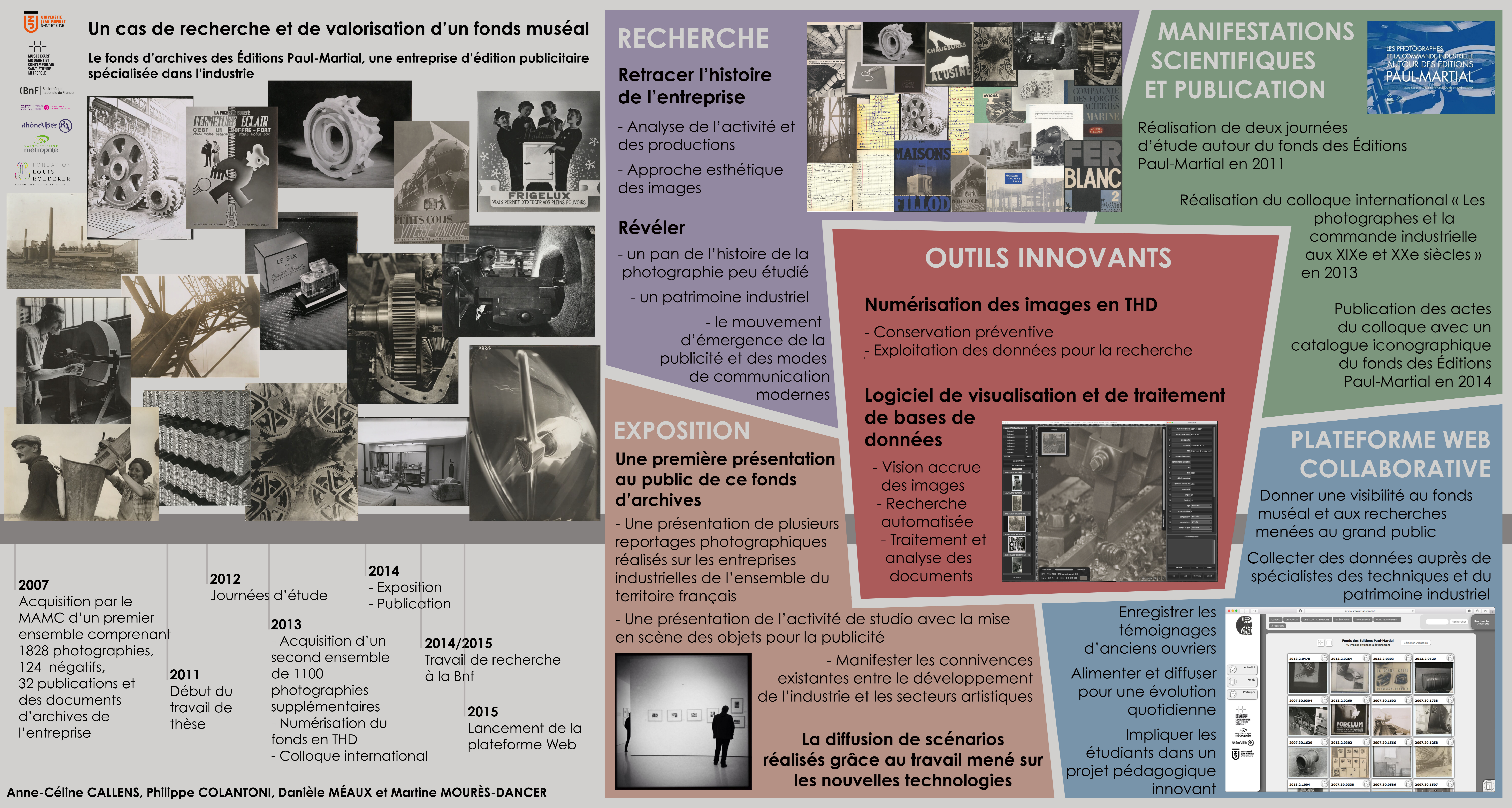

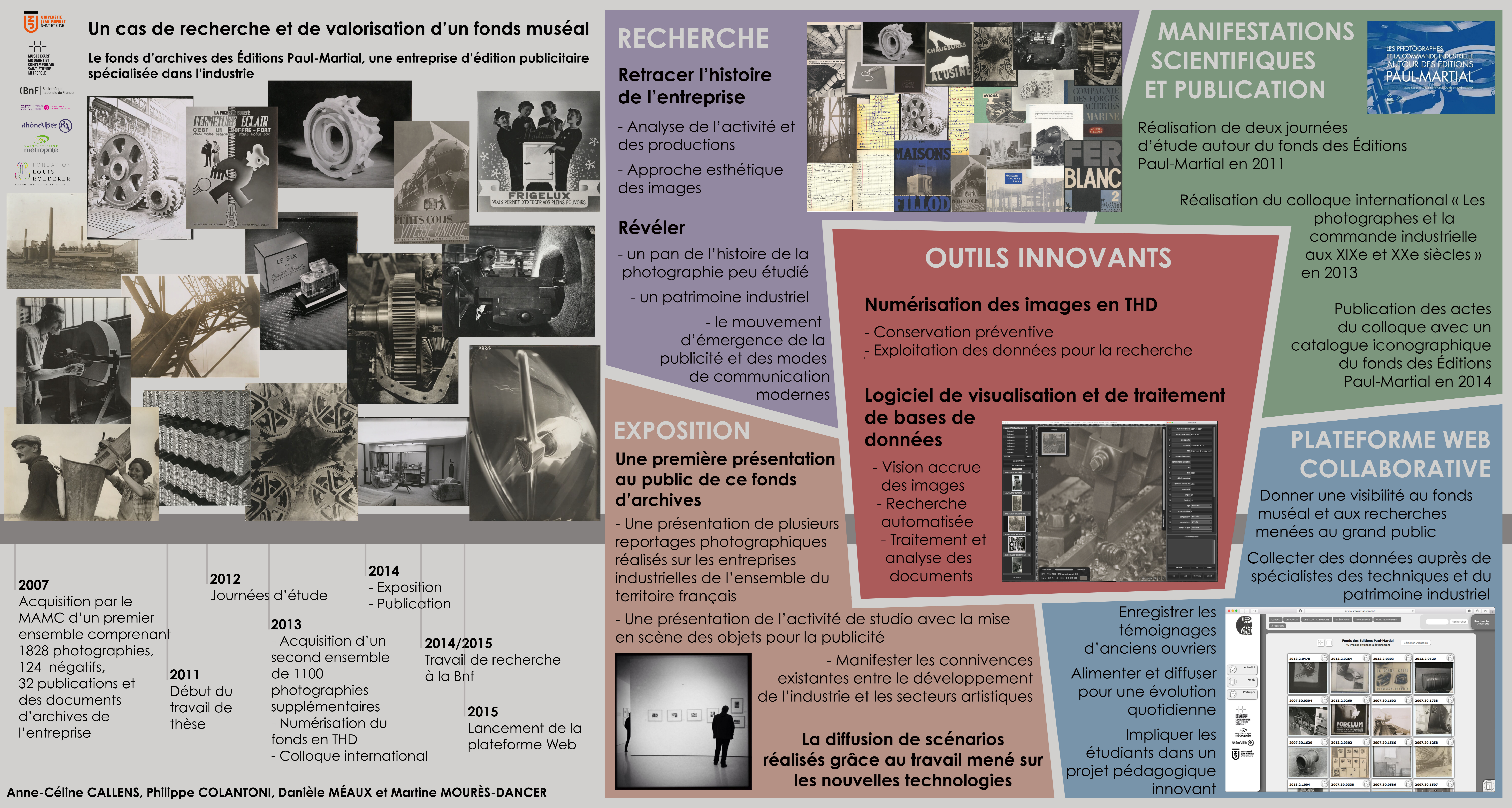

Un cas de recherche et de valorisation d’un fonds muséal :

le fonds d’archives des Éditions Paul-Martial, une entreprise d’édition publicitaire spécialisée dans l’industrie

Auteurs : A-C. Callens, P. Colantoni, D. Méaux (Université Jean Monnet Saint-Etienne, CIEREC), M. Mourès-Dancer (Musée d'art moderne et contemporain de Saint-Etienne Métropole)

Laboratoire : CIEREC (Centre Interdisciplinaire d'Etudes et de Recherches sur l'Expression Contemporaine)

Mots-clés : Fonds muséal, Publicité, Photographie industrielle, Base de données, Plateforme web, Système participatif, Médiation

Site : https://viva-arts.univ-st-etienne.fr

Résumé :

Contexte : Créée à Paris en 1926, l’entreprise des « Éditions Paul-Martial » bénéficie d’une renommée importante entre les deux guerres. Elle se spécialise dans l’industrie et propose à ses clients plusieurs types de prestations comme la conception de lignes graphiques, logos et affiches, d’encarts publiés dans les journaux et magazines spécialisés et l’édition de brochures, catalogues, dépliants, revues et ouvrages publicitaires. Elle est dotée d’ateliers de dessin, graphisme et typographie, d’une imprimerie, d’un studio photographique et réalise également des reportages en extérieur. Près de 47000 négatifs sont développés par l’entreprise entre 1929 et 1968. Les photographies rendent compte du monde du travail de l’entre-deux-guerres : aciéries et sidérurgies, chantiers navals, bâtiment et travaux publics, usines de construction mécanique, de fabrication textile, extraction d’énergie, laboratoires pharmaceutiques… L’entreprise compte parmi ses clients de nombreuses grandes sociétés industrielles comme la « SNCF », « Schneider », l’« OTUA », les chantiers de « Penhoët », « Citroën », et les avions « Henri Potez ». Les domaines artisanal et agricole ne sont pas en reste avec notamment « Moët et Chandon » et « Château Latour ». Les Éditions Paul-Martial s’impliquent également dans les domaines du prêt à porter et du luxe en travaillant avec des parfumeurs comme « Coty » et « Roger & Gallet » ou le grand couturier Paul Poiret. L'activité du pôle photographique de l'entreprise concerne trois pratiques : la prise de vue d’objets en studio, la reproduction de documents publicitaires en atelier et le reportage photographique en extérieur. Cette dernière catégorie concerne des vues d’architectures industrielles, de machines, d’objets issus de la production, mais aussi d’ouvriers dont les gestes du travail sont parfois finement détaillés. Aujourd’hui, les archives connues du studio photographique de l’entreprise sont réparties dans quatre grandes collections : celle du Musée d’art moderne et contemporain de Saint-Étienne Métropole (MAMC) — qui comprend 2902 tirages photographiques, 120 négatifs, 21 publications éditées par l’entreprise ainsi que plusieurs documents administratifs tels que des répertoires ou carnets référençant la production de la société —, celle du Kunstmuseum de Bâle, celle de l’expert Marc Pagneux, et celle du département des estampes et de la photographie de la Bibliothèque nationale de France qui comprend plusieurs centaines de tirages et plus de dix mille négatifs.

Recherche : Durant longtemps, l’esthétique et l’histoire de l’art se sont cantonnées à la prise en compte d’oeuvres reconnues, sanctionnées par certains modes d’exposition ou de publication qui certifient leur valeur. Jusqu’à une période récente, peu de considération était accordée aux travaux de commande tels que ceux réalisés par les Éditions Paul-Martial. Aujourd’hui, l’intérêt pour des documents ne relevant pas exclusivement du champ de l’art se développe et vient enrichir la connaissance du domaine de la photographie. L’étude des archives des « Éditions Paul-Martial » permet de caractériser une esthétique industrielle, révélatrice des façons de concevoir le monde du travail et de l’industrie au XXe siècle. Au vu de la conséquence de tels fonds, la question de la méthodologie de travail est primordiale. Il s’agit de développer une approche permettant d’optimiser l’exploitation des données.

En 2011 le Musée d’art moderne et contemporain de Saint-Étienne Métropole a entrepris, sous l’impulsion de Martine Mourès-Dancer, un vaste travail de recherche et de valorisation du fonds des Éditions Paul-Martial. Il a rassemblé un comité de pilotage composé de conservateurs et de spécialistes en histoire de l’art, des techniques, et en esthétique. Deux journées d’étude sur « La commande photographique en France aux xxe et xxie siècles » sont organisées en 2012. Le colloque international « Les photographes et la commande industrielle en Europe au xxe siècle » a lieu en 2013 ; les actes sont publiés l’année suivante sous la direction de Danièle Méaux et Martine Mourès-Dancer sous l’intitulé Les Photographes et la commande industrielle. Autour des Éditions Paul-Martial.

Outils innovants : Le CIEREC développe à la fin de l’année 2013 un système complet de numérisation permettant d’obtenir des documents en très haute définition, qu’il expérimente avec le fonds Paul-Martial du MAMC. Le pilotage de deux scanners professionnels calibrés à l'aide de chartes couleurs définies a permis la numérisation de 3355 documents avec une résolution de 1200 DPI et 48 bits par couleur, et la création d’une base de 2 To d'images calibrées. Outre l’aspect de conservation, ce système permet d’exploiter les documents dans le cadre de recherches scientifiques. Un logiciel spécifique de visualisation et de traitement de bases de données a été créé avec deux objectifs : le premier vise à améliorer la compréhension des documents à travers une lecture accrue. Jusqu’alors ignorés car invisibles à l’oeil nu, certains aspects des images sont dévoilés et permettent notamment de dater certaines épreuves, identifier les entreprises, lire un numéro de série sur une machine, distinguer la marque et le contenu d’un produit sur son emballage, accéder à la compréhension de certains mécanismes de fonctionnement des machines, de façonnage des pièces ou encore de gestes du travail. Le second objectif vise à traiter et exploiter la masse de documents du fonds. Les images ont été annotées avec précision pour permettre des recherches automatiques dégageant plusieurs types de classements. De nombreux aspects ont pu être dégagés : les images ont été reclassées dans leur chronologie de réalisation, les différents reportages ont pu être reconstitués et situés géographiquement, les entreprises et domaines d’activité ont pu être identifiés …

Exposition : L’exposition Les Éditions Paul-Martial : la belle publicité s’est tenue au MAMC à l’automne 2014 sous le commissariat d’Anne-Céline Callens et Martine Mourès-Dancer. Pour cette première grande présentation au public, il s’agissait de manifester les connivences entre le développement de l’industrie et les secteurs artistiques. Trois aspects ont été privilégiés : la monstration de plusieurs reportages photographiques réalisés auprès des entreprises industrielles sur l’ensemble du territoire français ; la présentation de l’activité de studio de l’entreprise avec la mise en scène des objets pour la publicité ; la diffusion de scénarios réalisés grâce au travail mené par le CIEREC sur les nouvelles technologies.

Plateforme Web collaborative : Les informations issues des études pluridisciplinaires menées sur le fonds des Éditions Paul-Martial bénéficient aujourd’hui d’une large diffusion : une visibilité leur est donnée par une plateforme web dédiée, créée en 2015, qui propose un espace de visualisation et de classification des 3355 documents numérisés. Une documentation précise des photographies du fonds Paul-Martial a été réalisée et intégrée au sein de la plateforme Web collaborative. Une prospection est également en cours auprès de spécialistes en histoire, histoire des techniques, sociologie, associations de préservation du patrimoine industriel ou encore anciens employés des usines pour enrichir la connaissance du contenu des images. La plateforme vise enfin l’enrichissement des connaissances grâce à l’utilisation d’outils collaboratifs : sous la supervision d’un modérateur, les visiteurs peuvent décrire et annoter les images. Une cartographie interactive permet de localiser les lieux de prise de vue des différentes photographies. Conçus pour une accessibilité au grand public, les contenus sont simples et didactiques afin que séniors et enfants puissent interagir avec la plateforme. Un travail pédagogique innovant autour de ces images vient d’être lancé. Il vise à impliquer les étudiants, toutes disciplines confondues (arts plastiques, histoire, sociologie, information-communication, sciences de l’ingénieur, etc), qui pourront apporter leur regard sur une ou plusieurs image(s) de leur choix.

Ces différents projets de recherche ont reçu le soutien financier de Saint-Étienne Métropole, de la région Rhône-Alpes, du musée d’art moderne et contemporain de Saint-Étienne Métropole, et de l’Université Jean Monnet de Saint-Étienne.

Publications

MÉAUX D. et MOURÈS-DANCER M. dir., Les Photographes et la commande industrielle. Autour des Éditions Paul-Martial, Saint-Étienne, Musée d’art moderne et contemporain, 2014.

CALLENS A.-C., « Ästhetik der industrie. Die Fotografien der Éditions Paul-Martial », Rundbrief Fotografie, Vol. 22, No. 4, Analoge und digitale Bildmedien in Archiven und Sammlungen, décembre 2015, p. 31-40.

CALLENS A.-C., « Fonction / Matériau / Forme : la représentation de l’architecture industrielle par les photographes des Éditions Paul-Martial », in CALLENS A.-C. et JURADO BARROSO P. dir., Art, architecture, paysage. À l’époque post-industrielle, Saint-Étienne, PUSE, 2015, p. 21-35.

CALLENS A.-C., « Paul-Martial Haeffelin & Cie, eine werbeagentur », in Paul-Martials welt der gewöhnlichen dinge, Neu erworbene fotografien aus der sammlung Herzog 5. Juli – 19. Oktober 2014, Kunstmuseum Basel – Kupferstichkabinett, Basel, Kunstmuseum Basel und die Autoren, 2014, p. 12-17.

*****

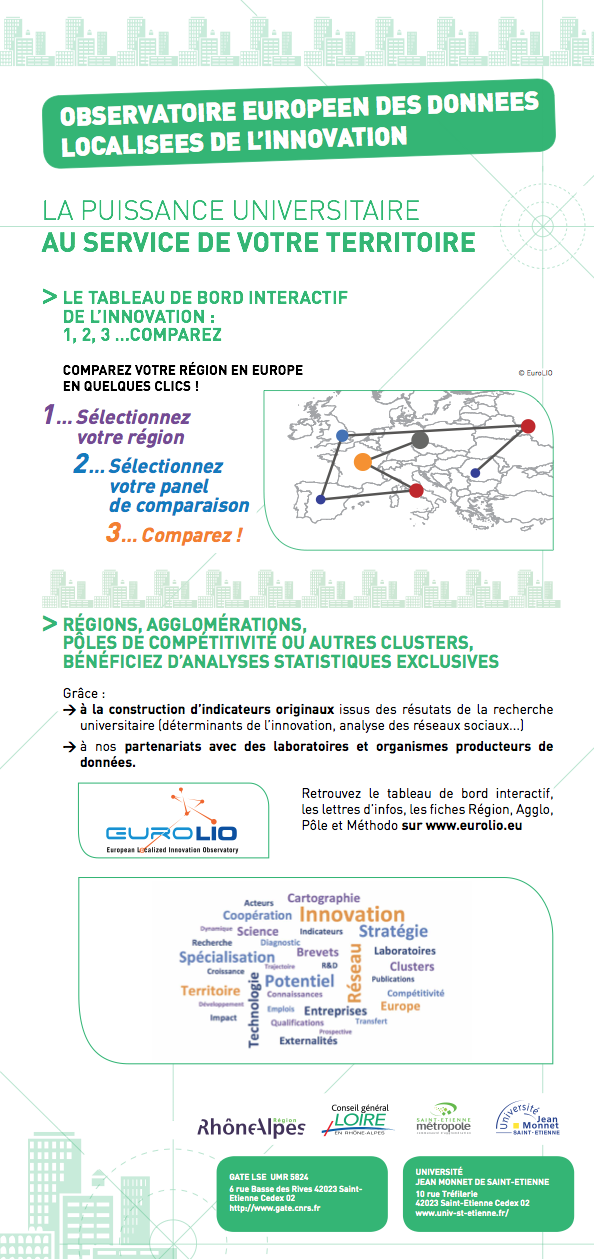

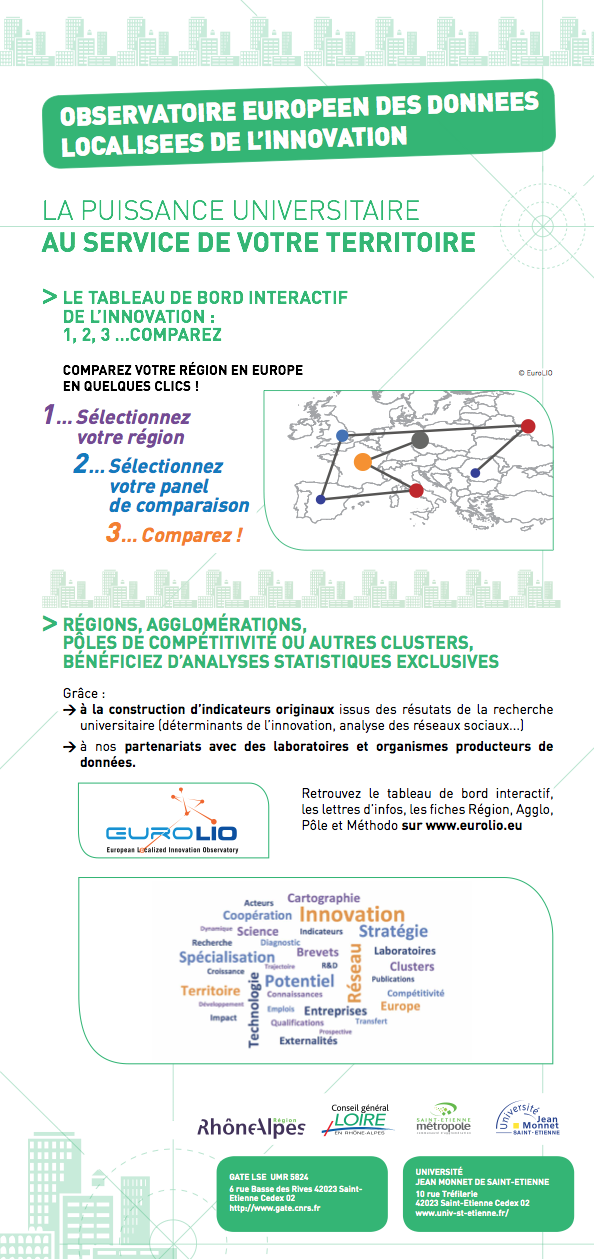

Observatoire européen des données localisées de l'innovation - EuroLIO

Auteur : C. Autant Bernard (Université Jean Monnet Saint-Etienne, GATE)

Laboratoire : GATE (Groupe d’Analyse et de Théorie Economique)

Mots-clés :

Site : http://eurolio.univ-st-etienne.fr

Résumé :

EuroLIO est l’Observatoire Européen des Données Localisées de l’Innovation. Le réseau constitué de 10 structures de recherche françaises :

A ces derniers sont associés de nombreux laboratoires d’autres pays européens disposant de ressources et de compétences dans le domaine de l’innovation territorialisée.

Le GATE-LSE est le laboratoire chef de file du réseau.

EuroLIO, c’est :

Le personnel permanent est composé de 2 ingénieurs d’études :

Nos missions

► Identifier, fédérer et coordonner les compétences grâce au centre de ressources en données et méthodologies d’analyse de l’innovation localisée

► Animer les interactions entre chercheurs, décideurs publics et producteurs de données dans le cadre d'un espace d’échange et de concertation : le comité d'orientation

► Diffuser l’information statistique sur les dynamiques locales d’innovation, par la parution de fiches et lettres d’information et par le Tableau de bord interactif, pour l’aide à la décision publique territoriale.

*****

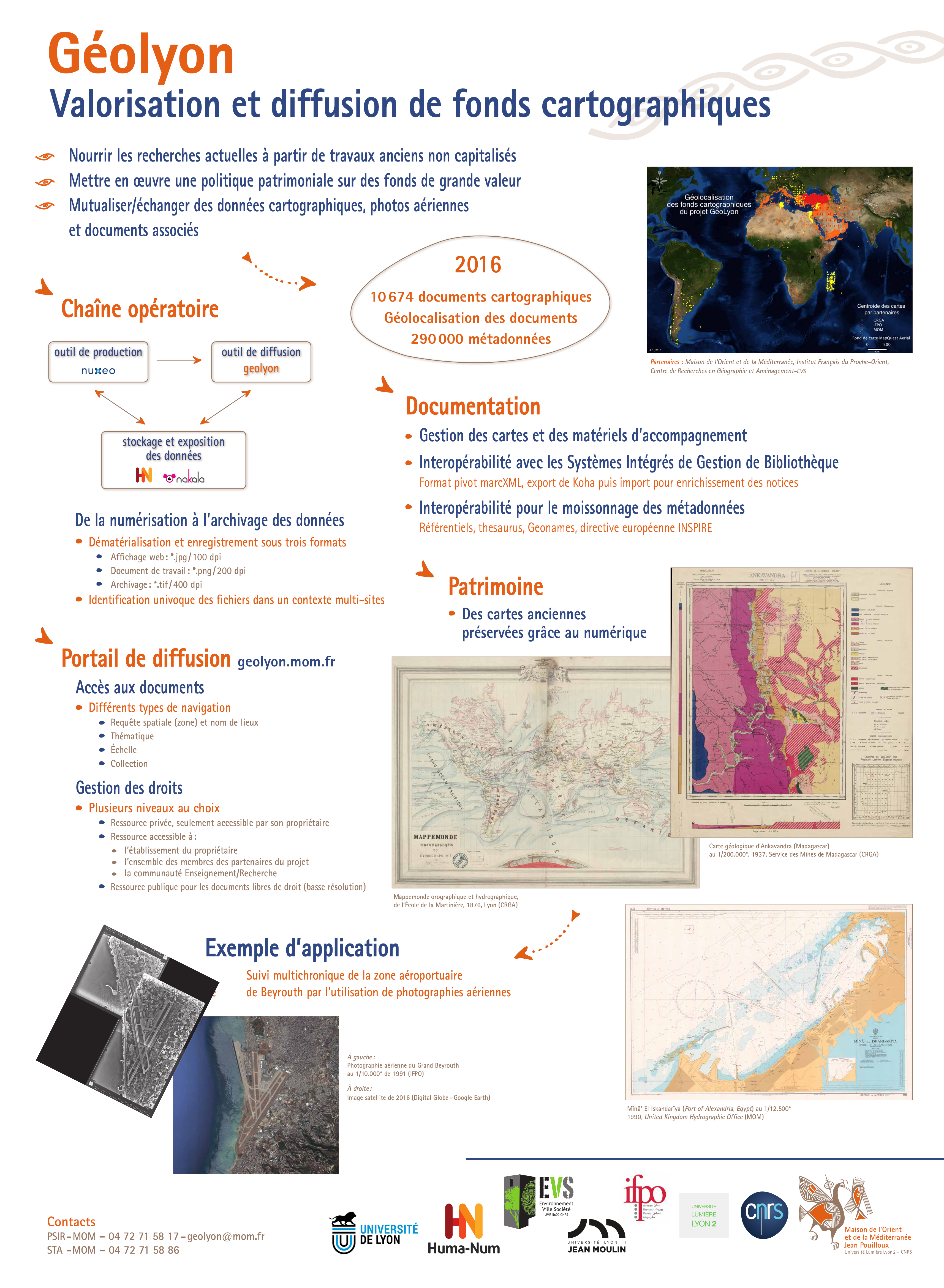

Géolyon, une plateforme de valorisation et de diffusion de fonds cartograophiques

Auteurs : B. Morandière*, P. Desfarges*, J. Erismann*, G. Charpentier**, D. Laisney**, (MOM) M-H. Barrière (Persée)

Services de la MOM :

*PSIR (Pôle Systèmes d'Informations et Réseaux)

**Techniques archéologiques

Mots-clés : Géolocalisation, fonds cartographiques, multi-partenaires, interopérabilité

Site : http://geolyon.mom.fr/GeoLyon/main

Résumé :

L’ambition de ce projet est de créer un véritable centre de ressources cartographiques conçu comme une structure de diffusion et d’information, fondé sur une accumulation et une capitalisation des données dynamiques. Il n’implique en aucune manière une centralisation de la donnée en un lieu précis et correspond à la mise en cohérence de la métadonnée et la mise en place d’un accès simple et unifié pour tous les documents. Il s’adresse à l’ensemble de la communauté scientifique avec deux types de partenariat : l’un régional par la participation des équipes de recherche dépendant des Universités de Lyon2 et Lyon3 (Il est souhaité à terme d’associer les fonds documentaires gérés par l’observatoire/Lyon1, par l’ENS et par l’ISH) ; l’autre international dans lequel s’inscrit l’Institut Français du Proche-Orient (IFPO) dont la plus grande partie du fonds documentaire cartographique complète les collections, spécia- lisées dans le Proche et Moyen Orient et les pays méditerranéens, gérées à la MSH-MOM. La mise en place d’un système fédératif, via Internet, doit permettre aux partenaires associés à ce programme, de recenser de manière très détaillée les ressources disponibles afin de les documenter et de les mettre en ligne. Ainsi, la diffusion de ces documents doit s’adres- ser en priorité, aux équipes de recherche (ayant droit/accès) en respectant les droits d’auteur. Une diffusion élargie à un public scientifique plus large est à mettre en place, avec l’appui des services juridiques de Lyon/2 et du CNRS.

La mutualisation des fonds cartographiques des partenaires

Les partenaires du projet disposent en propre d’importants fonds cartographiques (environ 19 000 titres pour Lyon 2, 30 000 titres pour Lyon 3 (répartis entre le CRGA et la cartothèque du service Commun de Documentation, sur deux sites différents) et 6 758 titres pour la MOM .Ce potentiel de mutualisation des fonds représente une ressource sans équivalent sur le site de Lyon et à l’échelle du grand Sud-Est français. Complémentaires en dehors du territoire métropolitain, les documents antérieurs à 1900 (réunis depuis la création de la faculté des Lettres dans les années 1830, avec un très gros apport après la création de l’Université de Lyon en 1896) représentent plusieurs milliers de titres. En raison de l’éclatement des structures universitaires, le fonds original a été divisé en plusieurs collections reparties entre Lyon 2 et Lyon 3. Après des années d’efforts suivis des personnes qui en étaient chargées, et avec des moyens très limités, il n’est qu’en partie inventorié, et selon des modalités hétérogènes. A cela s’ajoutent les 12 000 titres enregistrés à l’IFPO, répartis sur les sites de Damas, Beyrouth et Amman (la comparaison des collections de cartes entre l’IFPO et la MOM est en cours). 6 Ce projet a pour vocation d’agréger d’autres collections conséquentes, comme le laissent penser les premières réactions et prises de contact informelles qu’a généré la constitution de ce dossier (Lyon 1, CEA : Centre des Etudes Alexandrines).

La constitution d’un centre de ressources cartographiques commun

Dans un premier temps, il est prévu la mise en place d’un (des) serveur(s) en ligne, d’abord ouvert aux chercheurs et aux partenaires de l’opération. Les droits relatifs à la propriété physique des documents, à leur propriété intellectuelle, et à leur mise en ligne le cas échéant auprès du public, seront dûment respectés. Les services juridiques compétents seront consultés autant que de besoin sur ces questions.

L’élaboration d’un mode de diffusion via les portails des bibliothèques

Les informations documentaires de catalogage devront être également diffusées par les portails des bibliothèques des établissements. Afin que leurs utilisateurs soient informés des ressources disponibles, les webmestres auront la possibilité de moissonner les informations mutualisées dans le corpus constitué. Il est à noter que, dans le domaine de l’archéologie, le réseau Frantiq (Koha), auquel appartient la bibliothèque de la MOM, permettra l’enregistrement et la consultation des ressources cartographiques. Dans la mesure où ce portail propose un entrepôt de stockage des données ainsi qu’un moissonnage par le portail du TGE Adonis (HUMA-NUM), le projet collaborera directement à la définition d’un service OAI.

*****

Master Architecture de l'Information

Master labellisé Université de Lyon porté conjointement par ENS de Lyon, Université Lyon 1, enssib

Site : http://archinfo.universite-lyon.fr

Résumé :

Une formation innovante pour concevoir, préparer, organiser, présenter l'information aux utilisateurs dans un environnement numérique, intéractif et mobile!

On compte aujourd’hui plus d'un milliard de sites web et applications mobiles. Nous accédons aux ressources à partir de terminaux variés (ordinateurs, téléphones intelligents, tablettes) au travers d’outils divers (moteurs, réseaux sociaux, blogues, tweets... ou même directement). Dans un environnement aussi compétitif, la fidélité de l’internaute à une interface ou à une ressource dépend en grande partie de l’expérience de sa visite : a-t-il trouvé facilement l’information qu’il cherchait ? S’est-il senti immédiatement familier avec l’interface proposée ? Sera-t-il incité à y retourner ?

Il est aujourd’hui indispensable, pour des sites web riches en contenus, des sites de grandes institutions, à but lucratif ou non, pour leurs besoins internes comme leur communication externe, de faire appel à des spécialistes de l’organisation et du repérage de l’information, de même qu’à des spécialistes de l’expérience utilisateur. Ces deux domaines d’expertise convergent vers un même objectif : garantir un accès intuitif et facile au contenu, pour l’utilisateur d’une ressource web (ou, plus généralement, de tout système d’information).

On appelle les professionnels détenant ces expertises des Architectes de l’Information.

A la rentrée 2012, l'ENS de Lyon a ouvert le premier master francophone en Architecture de l'Information. A la rentrée 2014, le master a été cohabilité avec l'université Claude Bernard Lyon 1 et l'Ecole nationale supérieure des sciences de l'information et des bibliothèques et a été labellisé par l'Université de Lyon, comme master d'excellence. Dans le cadre de la réorganisation de l'ensemble des masters du pôle Lyon-St Etienne, celui-ci a rejoint, à la rentrée 2016, la mention Information et Communication transversale aux établissements, comme un parcours "Architecture de l'information". Il reste piloté par l'ENS de Lyon.

*****

Master Humanités Numériques à Lyon

Auteurs : Sabine Loudcher (Université Lyon 2, ICOM), Bruno Bureau (Université Lyon 3, HiSoMA), Isabelle Colon de Carvajal (ENS, ICAR), Eric Guichard (Enssib)

Laboratoires :

- ICOM (Institut de la Communication)

- HiSoMA (Histoire et Sources des Mondes Antiques)

- ICAR (Interactions, Corpus, Apprentissages, Représentations)

- Enssib (Ecole Nationale Supérieure des Sciences de l'Information et des Bibliothèques)

Sites :

http://icom.univ-lyon2.fr/fr/nos-formations/master/humanites-numeriques/

http://offreformation.univ-lyon2.fr/cdm/fr/fiche/objectifs/FRUAI0691775EPRME235

Résumé :

Nous avons le plaisir de vous annoncer la création d'une mention de Master Humanités Numériques à Lyon, avec l'ouverture de la 1ère année en septembre 2016.

Le master Humanités Numériques est co-accrédité par l’Université Lumière Lyon 2, l’Université Jean Moulin Lyon 3, l’École Normale Supérieure de Lyon et l’École Nationale Supérieure des Sciences de l’Information et des Bibliothèques. Il est adossé à plusieurs laboratoires de recherche en Sciences Humaines, en Sciences Sociales et en Informatique du site Lyon Saint-Etienne : CIHAM (UMR 5648), CREA (EA 3081), ECP (EA), ELICO (EA 4147), ERIC (EA 3083), EVS (UMR 5600), ISoMa (UMR 5189), ICAR (UMR 5191), LARHRA (UMR 5190), LIRIS (UMR 5205), Groupe MARGE/CEDFL (EA 3712), Triangle (UMR 5206).

L’objectif de ce master Humanités Numériques est préparer aux fonctions de niveau cadre qui nécessitent de comprendre de manière technique et critique les données et les documents, les outils et les méthodes numériques qui les produisent, leurs représentations, leurs analyses et leurs usages. Il s’agit d’articuler les problématiques et les méthodes des sciences humaines et sociales, de la statistique et de l’informatique, pour élaborer, analyser, interpréter socialement, scientifiquement et techniquement des objets numériques ou numérisés, majoritairement sous forme de corpus.

Le master Humanités Numériques est accessible uniquement en double-diplôme. Les étudiants doivent être inscrits principalement dans une mention de master disciplinaire (histoire, sciences de l’information et de la communication, anthropologie, archéologie, informatique…). Le master Humanités Numériques donne en inscription secondaire une spécialisation complémentaire et valorisable en permettant l’obtention de deux masters. Peuvent toutefois être acceptés en inscription principale dans le master Humanités Numériques des étudiants qui auraient déjà validé un master disciplinaire et voudraient acquérir en complément les connaissances et compétences enseignées dans ce master.

*****

Opentheso, gestionnaire de thesaurus multilingue gratuit et opensource

Auteurs : M. Rousset (MOM) - PSIR (Pôle Systèmes d'Informations et Réseaux)

Partenaires :

GDS Frantiq (Fédération Ressources sur l'Antiquité)

MAE (Maison de l'Archéologie et de l'Ethnologie)

TGIR Huma-Num

Résumé :

Opentheso est un gestionnaire de thésaurus multilingue supportant la poly-hiérarchie, conforme à la norme ISO 25964 (1 - Thésaurus pour la recherche documentaire ; 2 - Interopérabilité avec d'autres vocabulaires).

Fonctionnalités de gestion:

- gestion avancée de l'arborescence du thésaurus et des concepts : pas de limitation connue dans le nombre de branches ni des niveaux hiérarchiques ; déplacement de branches ; création, modification, fusion, suppression des termes et de leur environnement, enrichissement des termes (traduction, illustrations, alignements,…) ; historique des concepts ; gestion des candidats

- trois niveaux d'autorisation

- interfaces de consultation multilingue et de production en français/anglais

- affichage du thésaurus sous forme de liste hiérarchisée, alphabétique et permutée ; constitution de facettes ou regroupements virtuels de termes.

- recherche sur tout ou partie du thésaurus dans toutes les langues (UNICODE)

- statistiques

- import/export de termes ou de branches en CSV, XML-SKOS, JSon-LD

Fonctionnalitéss d'ouverture des données :

- identifiants pérennes (ARK, et autres possibles)

- alignements (conforme à la norme ISO 25964-2 - Interopérabilité avec d'autres vocabulaires)

- API WebServices SOAP, REST

*****

Persée, une plateforme ouverte pour la numérisation, l’enrichissement

et la diffusion de vastes collections et corpus documentaires

Auteurs : N. Fargier (Persée)

Laboratoire : UMS 3602

Site internet : http://persee.fr

Résumé :

Pour ses 10 ans, Persée, plateforme de valorisation du patrimoine scientifique, dévoile son nouveau site. Diffusant près de 550.000 documents, le site Persée accueille plus de 25 millions de visites par an. Il a été entièrement repensé et enrichi et il offre aux chercheurs et étudiants une expérience utilisateur innovante.

À la suite d'une enquête à laquelle plus de 5 000 personnes ont répondu, le nouveau site fait écho aux besoins actuels des chercheurs et des étudiants. Il est en ligne depuis le 28 septembre 2015.

Les modalités de recherche et les parcours de navigation ont été repensés avec une mise en valeur de la richesse iconographique présente dans les publications scientifiques. Le nouveau site, au design résolument moderne, propose un index des auteurs et des possibilités d’interaction avec le web de données. Cette réalisation est le fruit d’un partenariat avec l'Agence Bibliographique de l’Enseignement Supérieur (ABES). Pour chaque auteur, il est désormais possible d’obtenir une fiche complète comprenant ses publications, collaborations et citations ainsi que des rebonds vers d’autres sites et applications comme idREF, data.bnf.fr, Wikipédia et DBpedia. Possibilités avancées de recherche, indexation précise, export des références bibliographiques, téléchargement de fichiers PDF, liens entre documents sont autant de possibilités pour les chercheurs d’exploiter les fonds patrimoniaux de Persée. Si les évolutions fonctionnelles sont nombreuses, Persée reste fidèle à son engagement en faveur de l’ouverture des données : l’accès au texte intégral des documents est totalement libre.

Persée est une Unité Mixte de Services réunissant l’Université de Lyon, le CNRS et l’ENS de Lyon et bénéficiant du soutien du MENESR. Sa mission — au bénéfice de la communauté de l’enseignement supérieur et de la recherche — est la valorisation numérique du patrimoine scientifique. Numériser, structurer, enrichir et diffuser des collections et des corpus sont au coeur de ses activités. Depuis 2005, le portail Persée offre un accès libre et gratuit à des collections complètes de publications scientifiques, principalement dans le domaine des sciences humaines et sociales. Il s’ouvre à de nouvelles disciplines et accueille désormais des publications en sciences et techniques ainsi qu’en sciences et vie de la terre.

*****

Projet Marc Michel Rey

Auteurs : C. Bahier-Porte (UJM, IHRIM), A. Mckenna (UJM, IHRIM), F. Vial-Bonacci (CNRS, IHRIM), V. Beaugiraud (ENS de Lyon), M. Ingarao (ENS de Lyon)

Laboratoire :

- IHRIM (Institut d’Histoire des Représentations et des Idées dans les Modernités)

Contact : ihrim-rey@univ-st-etienne.fr

Mots clés : correspondance, librairie, histoire du livre, histoire des idées, Lumières, réseaux

Site : http://rey.huma-num.fr

Résumé :

Marc-Michel Rey (1720-1780) est un libraire imprimeur né à Genève et installé à Amsterdam à partir de 1746, date à laquelle les premiers ouvrages à son adresse paraissent. En janvier 1754, Rey se fait connaître par sa réimpression du Journal des savants, combiné avec les Mémoires de Trévoux. Il est l’éditeur de Voltaire, de Rousseau, Diderot, d’Holbach. La correspondance de Marc Michel Rey permet de mieux comprendre le système de la librairie au dix-huitième siècle, la manière dont se constitue un réseau à la fois commercial et intellectuel. Le projet se trouve ainsi à la croisée de l’histoire du livre et de l’histoire des idées et de diffusion la pensée des Lumières, dont on découvre les coulisses ou, pour mieux dire, l’atelier.

Le projet Marc Michel Rey consiste à éditer l’ensemble de la correspondance du libraire imprimeur Marc-Michel Rey, ainsi que ses archives de libraire (comptabilité, catalogues…). La plus grande partie de ces documents (environ 2000 documents) est inédite et est le fruit d’un travail de recherche effectué par Jeroom Vercruysse, professeur à Bruxelles, lequel a confié son travail pour édition à l’équipe stéphanoise de l’IHRIM (ex IHPC). Des découvertes récentes dans des bibliothèques française et européenne ont encore permis d’enrichir le corpus de lettres. Nul doute que d’autres découvertes sont encore possibles, précisément grâce au numérique.

À ce jour, l’inventaire critique de tous ces documents a été réalisé et est disponible en ligne. La construction du site a bénéficié de l’aide de l’Atelier des humanités numériques de l’ENS et relève d’un travail collaboratif pour établir la meilleure méthodologie possible (choix du type d’encodage XML selon les documents, logiciel BaseX et générateur de pages web SynopsX , choix du logiciel et de la méthode d’édition… ). Le site a été accepté par la TGIR Huma-Num (rey.huma-num.fr). Le projet, soutenu par le labex COMOD, sera prochainement soumis au consortium CAHIER.

Le projet Marc Michel Rey n’en est qu’à sa première étape avec la publication de cet inventaire, dès septembre 2016, l’édition critique de la correspondance commencera à être mise en ligne. Une réflexion est également en cours sur l’évolution des fonctionnalités du site : section documents en ligne, partage d’informations, liens avec les catalogues des bibliothèques européennes etc.

À la différence d’autres projets éditoriaux qui associent la publication « papier » et le support électronique, le projet Marc Michel Rey est entièrement numérique.

Le poster propose ainsi de présenter :

- L’état actuel du site Marc Michel Rey et ses fonctionnalités

- La méthodologie choisie tant pour les données que pour l’édition (les questions qui se posent et difficultés rencontrées)

- Le projet de développement du site : édition critique des lettres, catalogues de librairie, documents.

*****

Le projet symogih.org, un système modulaire de gestion de l'information historique

Auteurs : Vincent Alamercery (ENS de Lyon), Francesco Beretta (ISH), Sylvain Boschetto (ISH), Claire-Charlotte Butez (ISH), Djamel Ferhod (ISH), Séverine Gedzelman (ENS de Lyon) ; en collaboration avec le Pôle histoire numérique du LARHRA

Laboratoires : LARHRA (Laboratoire de recherche historique Rhône-Alpes)

Mots clés : base de données, édition numérique, histoire numérique, modélisation, ontologie, système d'information géo-historique, web sémantique

Site : http://www.symogih.org

Résumé :

Le projet symogih.org a conçu une plateforme modulaire et ouverte pour héberger les informations géo-historiques. La plateforme, accessible par le web, permet aux chercheurs de partager leurs données et leurs textes dans un environnement collaboratif et de produire ainsi des données structurées concernant tous les champs historiques. Les corpus relatifs aux différents projets sont publiés sur des sites web dédiés (Patrons de France ; SIPROJURIS ; Society Religion Science). Un atlas historique des territoires politiques est également en cours de développement.

La richesse et l'hétérogénéité de l'information partagée requiert un modèle générique de données qui a été conçu avec la méthode Merise et intégré dans une base de données relationnelles PostgreSQL à laquelle les utilisateurs se connectent par une application web. En parallèle, le projet symogih.org a déployé un environnement pour analyser, partager et publier des textes encodés en XML/TEI en utilisant la plateforme eXist-db. L'annotation sémantique des entités nommées et des unités de connaissance est accomplie en reliant les balises sémantiques définies en ligne avec la Text Encoding Initiative (TEI) aux ressources créées dans la base de données relationnelles.

L'ensemble du système est interopérable et en cours d'alignement avec d'autres ressources du web des données et référentiels d'autorité. Une portion croissante des informations sont accessibles au format RDF par un point d'accès SPARQL par un point d'accès SPARQL, permettant une interrogation des données du projet symogih.org et, en même temps, de celles issues d'autres entrepôts du web des données.

Le poster présente le schéma du système, la méthodologie utilisée et des exemples de résultats. En outre, il présente les perspectives d'évolution du projet pour permettre à une communauté de plus en plus large d'utilisateurs de participer à la transition numérique et collaborative de la méthode de recherche en histoire.

*****

SynopsX : a Lightweight Xquery Based XML Publishing Framework

Auteurs : V. Beaugiraud, S. Boschetto, C. Boulai, E. Chateau, S. Gedzelman, M. Ingarao, P-Y. Jallud, J-P. Magué, E. Morlock, P. Pons, S. Saïdi, V. Ventresque

Laboratoires :

- ahn (Atelier Humanités Numériques)

- Centre Blaise Pascal

- ICAR (Interactions, Corpus, Apprentissages, Représentations)

- IHRIM (Institut d’Histoire des Représentations et des Idées dans les Modernités)

- HiSoMA (Histoire et Sources des Mondes Antiques)

- LARHRA (Laboratoire de Recherche Historique Rhône-Alpes)

- Triangle (Action, Discours, Pensée politique et économique)

avec le soutien du Labex 'Pasts in the Present'

Sites :

Présentation : http://ahn.ens-lyon.fr/synopsx

Code source : https://github.com/synopsx/synopsx

Résumé :

SynopsX est un système de publication léger, entièrement fondé sur des technologies XML à partir de la base de données XML native BaseX. Initié par l'Atelier des Humanités Numériques de Lyon (AHN), le projet est développé comme logiciel libre par une équipe de plusieurs contributeurs issus du monde académique. Le logiciel libre et open source est basé sur les fonctionnalités RESTXQ implémentées par BaseX.

Dans son état actuel, le logiciel permet :

- une publication personnalisée de sources textuelles XML-TEI,

- une publication d'entrepôt OAI-PMH,

- une articulation entre des sources EAD et XML-TEI,

- de disposer d'un moteur de recherche sommaire,

Le code du logiciel se caractérise par son extrême concision et son caractère modulaire. Il est donc très aisé de se l'approprier et de l'adapter à ses propres besoins. Ce logiciel est déjà en production pour différentes applications web de l'ENS Lyon. Plusieurs partenaires membres du consortium Cahier lyonnais et parisiens (ANR Ampère, et Projet des Guides de Paris notamment) participent déjà au projet.

*****

Auteurs : M. Burghart (CNRS)

Laboratoire : CIHAM (Histoire, Archéologie, Littératures des mondes chrétiens et musulmans médiévaux)

Site internet : http://ciham-digital.huma-num.fr/teitoolbox/

Résumé :

The TEI Critical Edition Toolbox is a tool for people preparing a natively digital TEI critical edition.

The Toolbox lets you:

* Check your encoding: offers facilities to display your edition while it is still in the making, and check the consistency of your encoding

* Display parallel versions: choose the sigla of the witnesses, and the different versions of the text, following each chosen witness, will be displayed in parallel columns.